YAML Metadata

Warning:

empty or missing yaml metadata in repo card

(https://huggingface.co/docs/hub/model-cards#model-card-metadata)

llama-3.2-1B-MS-MARCO-QLoRA

Este modelo es una versión afinada del modelo meta-llama/Llama-3.2-1B utilizando el conjunto de datos MS MARCO para tareas de generación de respuestas.

Descripción del Modelo

- Modelo Base: meta-llama/Llama-3.2-1B

- Técnicas Utilizadas:

- Quantization con QLoRA

- Afinación con LoRA y PEFT

- Arquitectura:

- Parámetros entrenables: Solo los adaptadores LoRA

- Parámetros totales: 771819520

- Parámetros entrenables: 22544384

Conjunto de Datos

- Nombre del Conjunto de Datos: MS MARCO

- Descripción: Conjunto de datos de comprensión lectora a gran escala que incluye preguntas y respuestas reales de usuarios.

- Tamaño del Conjunto de Entrenamiento: 56588

- Tamaño del Conjunto de Validación: 14148

- Preprocesamiento:

- Limpieza de texto

- Tokenización

- Creación de prompts combinando contexto, pregunta y respuesta

Entrenamiento

- Hiperparámetros:

- Número de épocas: 7

- Tamaño de lote de entrenamiento: 16

- Tamaño de lote de evaluación: 8

- Tasa de aprendizaje: 0.0002

- Configuración de LoRA:

- r (rango): 32

- lora_alpha: 32

- lora_dropout: 0.05

- Recursos Computacionales:

- Dispositivo: cuda

- Memoria GPU utilizada: A100(40gb)

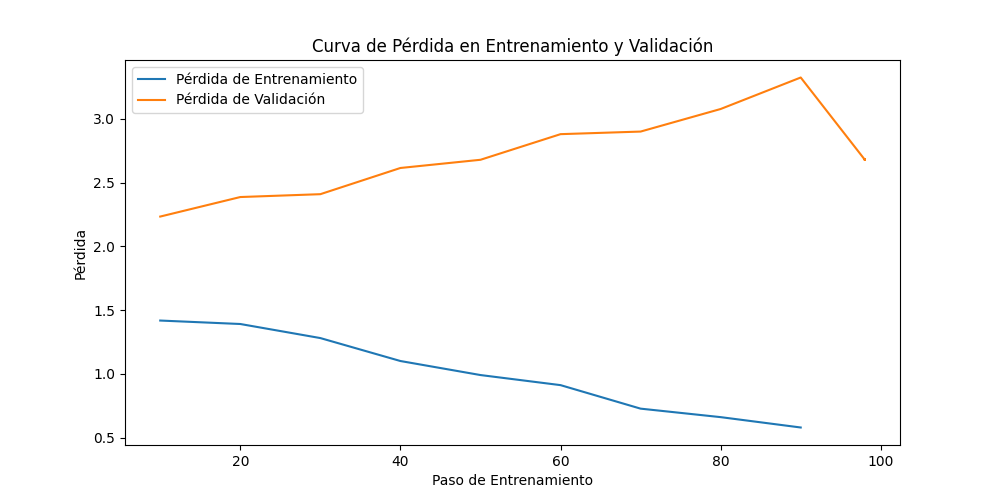

Resultados

Métricas

- Pérdida de Entrenamiento Final: 0.5787

- Pérdida de Validación Final: 2.6848

Gráficas

Uso del Modelo

Para utilizar este modelo, puedes cargarlo de la siguiente manera:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained('TheBug95/llama-3.2-1B-MS-MARCO-QLoRA')

tokenizer = AutoTokenizer.from_pretrained('TheBug95/llama-3.2-1B-MS-MARCO-QLoRA')