conversations

listlengths 2

2

| source

stringclasses 1

value | score

float64 1

1

|

|---|---|---|

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频开发准备"

},

{

"from": "gpt",

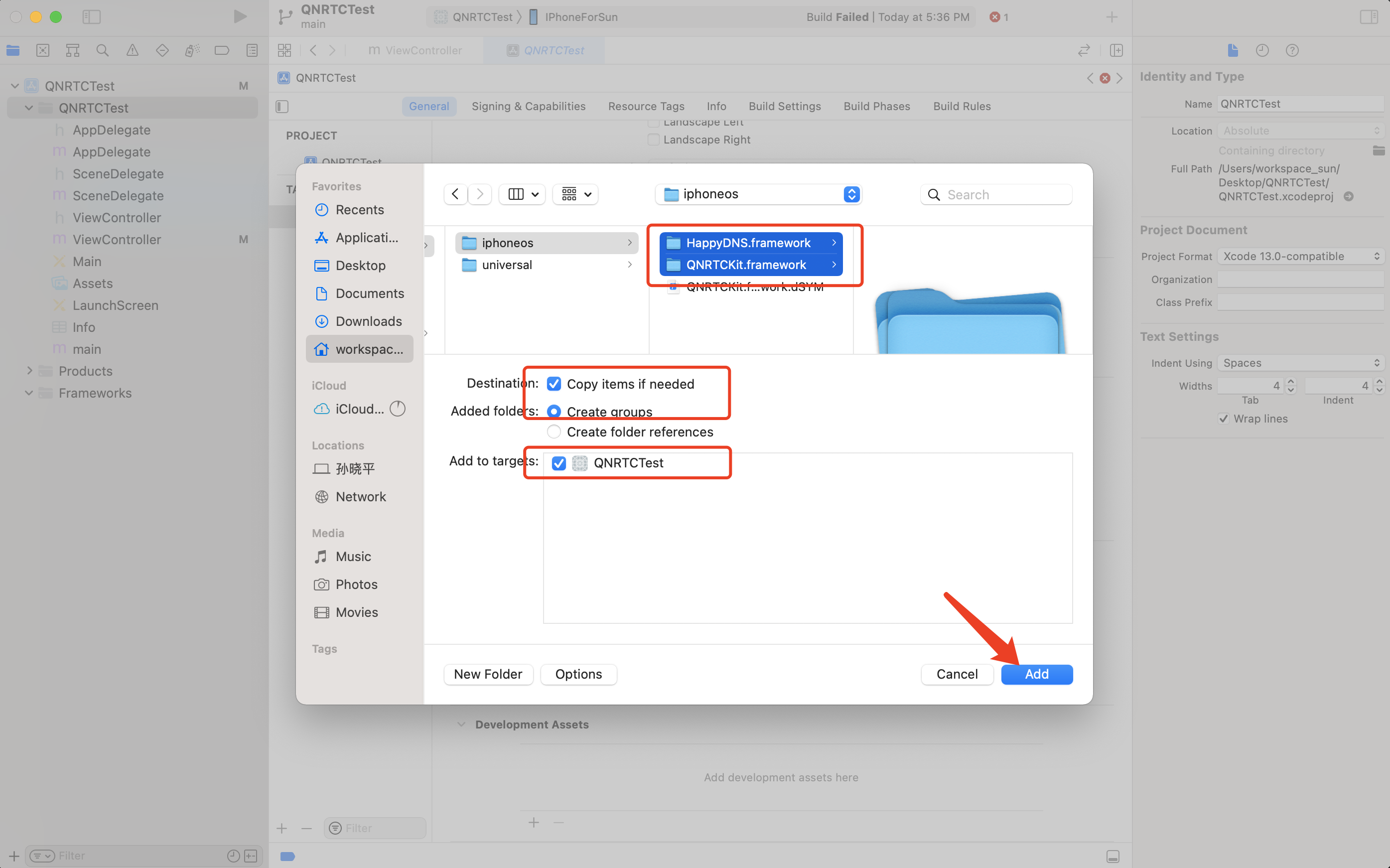

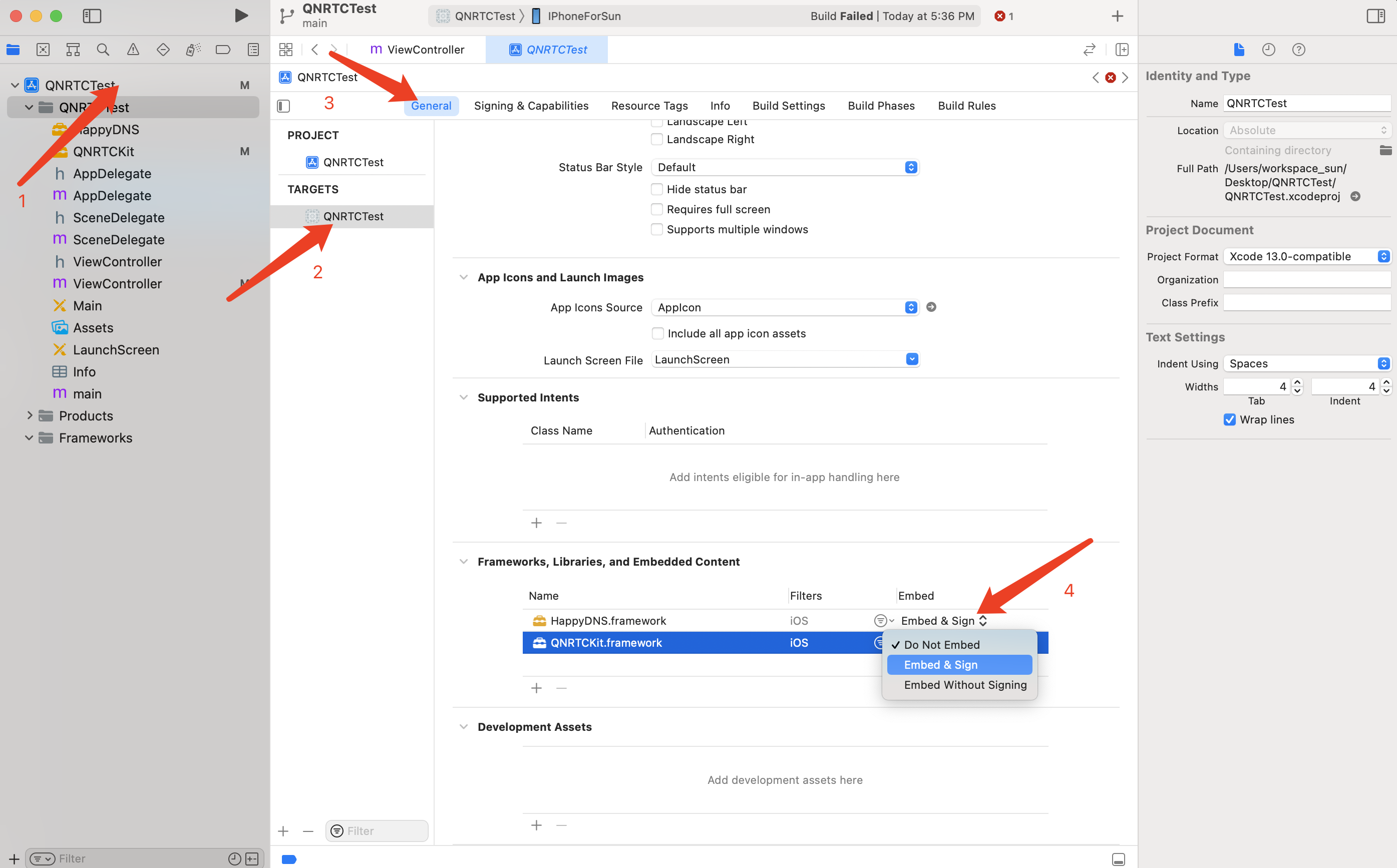

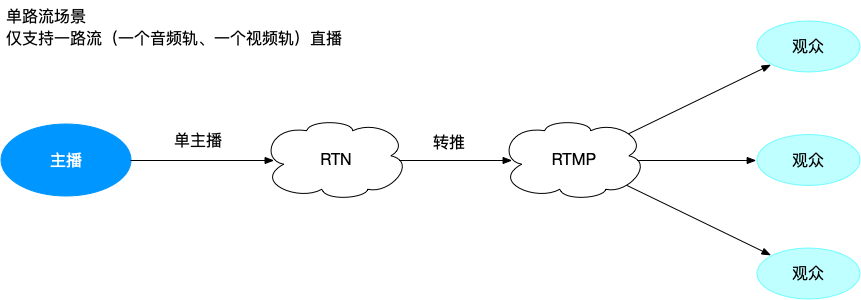

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > iOS >开发准备\n\n# 开发准备\n\n最近更新时间: 2023-03-10 10:52:54\n\n本文主要介绍开发前的准备工作,包括设备、系统及开发环境的要求等。\n\n# 设备以及系统要求\n\n * 设备要求:iPhone 5s 及以上\n * 系统要求:iOS 9.0 及以上\n\n# 开发环境\n\n * Xcode 开发工具。[App Store下载地址](https://itunes.apple.com/cn/app/xcode/id497799835?ls=1&mt=12)\n * 安装 CocoaPods。[了解 CocoaPods 使用方法](https://guides.cocoapods.org/)\n\n# 版本升级需知\n\n * v5.0.0 版本起,去除 HappyDNS.framework\n * v5.1.0 版本起,开始使用 FFmpeg,版本号为 v4.1\n\n> 注意:会与其它同样使用 FFmpeg 的 SDK 产生符号重复。为避免冲突,建议相同的依赖库只保留一份。\n>\n> 一般 Xcode Build 时,不会提示符号重复。但程序运行时,会出现崩溃。可在 “Build Settings” -> “Other Linker\n> Flags” 下添加 “-all_load” 选项,将使 Xcode Build 时,提示具体是哪个 SDK 存在符号重复。\n\n# 导入实时音视频 SDK\n\n## 通过 CocoaPods 导入\n\n[CocoaPods](https://cocoapods.org/) 是针对 Swift 和 Objective-C 的依赖管理工具,它能够将使用类似\nQNRTCKit-iOS 的第三方库的安装过程变得非常简单和自动化,您能够用下面的命令来安装它:\n\n \n \n $ sudo gem install cocoapods\n \n\n### Podfile\n\n为了使用 CocoaPods 集成 QNRTCKit-iOS 到您的 Xcode 工程当中,您需要编写您的 `Podfile`\n\n \n \n target 'TargetName' do\n pod 'QNRTCKit-iOS'\n end\n \n\n默认为真机版,若需要使用模拟器 + 真机版,则改用如下配置\n\n \n \n pod \"QNRTCKit-iOS\", :podspec => 'https://raw.githubusercontent.com/pili-engineering/QNRTC-iOS/master/QNRTCKit-iOS-universal.podspec'\n \n\n> 注意:鉴于目前上架 App Store 时只支持动态库真机版本,请在 App 上架前更换至真机版本。\n\n然后,运行如下的命令:\n\n \n \n $ pod install\n \n\n## 手动导入\n\n[点击下载](https://github.com/pili-engineering/QNRTC-iOS/tree/master/Pod)相应版本的\nSDK,将下载好的动态库文件 QNRTCKit.framework 导入到您的 Xcode 工程当中。\n\n动态库链接到工程中的方式,如下所示:\n\n * **Step 1:**\n\n右键当前项目文件夹,选择 `Add Files to xxx` \n\n * **Step 2:**\n * 选中 `Destination` 的 `Copy items if needed`\n * 选中 `Added folders` 的 `Create groups`\n * 选中 `Add to targets` 中需要引入 SDK 的 Target\n * 找到刚下载好的 QNRTCKit.framework\n * 点击 `Add`\n\n\n\n * **Step 3:**\n\n在项目工程配置 `General` 中将两个 SDK 的 `Embed` 设置为 `Embed & Sign`\n\n\n * **Step 4:**\n\n在需要使用的类中引入头文件\n\n \n \n #import <QNRTCKit/QNRTCKit.h>\n \n\n> 注意:\n>\n> 1)如果运行后程序 crash,报错信息标识**动态库无法找到`image not found`**,说明 SDK 没有正常\n> Embed,可以按文档流程重新引入一次。示例中使用的 xcode 版本为 Version 13.1 (13A1030d),其他版本 xcode\n> 的动态库引入方式可能会有差异。\n>\n> 2)从 v5.1.0 起,请务必在工程配置 “Build Phases” -> “Link Binary With Libraries” 下添加\n> libbz2.tbd、libiconv.tbd、libz.tbd 系统配置库。\n\n# 添加相关权限\n\n我们需要在 Info.plist 文件中添加相应权限的说明,否则程序在 iOS 10 及以上系统会出现崩溃。需要添加如下权限:\n\n * 麦克风权限:Privacy - Microphone Usage Description 是否允许 App 使用麦克风\n * 相机权限:Privacy - Camera Usage Description 是否允许 App 使用相机\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频实现视频通话"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > iOS >实现视频通话\n\n# 实现视频通话\n\n最近更新时间: 2024-07-15 14:41:19\n\n本文将介绍如何快速实现一个基本的实时音视频应用,该应用拥有 SDK 基本的连麦功能,包括 **加入房间** 、**采集** 、**发布** 、**订阅**\n等过程。\n\n> 若您的开发环境还没有搭建完成,SDK\n> 还未导入,请先参考[开发准备](https://developer.qiniu.com/rtc/quick_start/8831/prepare-\n> ios-development)文档进行 SDK 的导入等工作。 若您对实时音视频的**发布** 、**订阅**\n> 等基本流程还不熟悉,请先参考[基本概念](https://developer.qiniu.com/rtc/quick_start/9909/the-\n> rtc-basic-concept)对实时音视频通话过程中的相关概念略作了解。\n\n# 初始化\n\n首先,在进行 SDK 接口调用之前,需要在 viewController 生命周期中的 viewDidLoad 中进行初始化操作:\n\n \n \n QNRTCConfiguration *configuration = [QNRTCConfiguration defaultConfiguration];\n [QNRTC initRTC:configuration];\n \n\n# 添加视频渲染视图\n\n用户需要在 self.view 视图布局中期望的位置,添加两个 View 分别用来做本地视频画面预览窗口和远端视频画面渲染窗口。\n\n示例代码如下:\n\n \n \n QNVideoGLView *localPreview = [[QNVideoGLView alloc] init];\n localPreview.frame = CGRectMake(0, 0, 360, 640);\n [self.view addSubview:localPreview];\n \n QNVideoGLView *remoteView = [[QNVideoGLView alloc] init];\n remoteView.frame = CGRectMake(0, 640, 360, 640);\n [self.view addSubview:remoteView];\n \n\n# 创建音视频通话核心类\n\n本操作推荐在 viewController 生命周期中的 viewDidLoad 中完成\n\n \n \n QNRTCClient *rtcClient = [QNRTC createRTCClient];\n rtcClient.delegate = self;\n \n\n其中,rtcClient.delegate 是\n[QNRTCClientDelegate](https://developer.qiniu.com/rtc/api/9248/QNRTCClientDelegate)\n对象,[QNRTCClientDelegate](https://developer.qiniu.com/rtc/api/9248/QNRTCClientDelegate)\n为音视频通话过程中必须实现的事件回调代理。\n\n# 创建音视频采集 Track\n\nTrack 代表了音视频通话过程中的一路音频或者一路视频,本文仅介绍一路音视频连麦的场景,创建方式如下:\n\n \n \n QNCameraVideoTrack *cameraVideoTrack = [QNRTC createCameraVideoTrack];\n QNMicrophoneAudioTrack *microphoneAudioTrack = [QNRTC createMicrophoneAudioTrack];\n \n\n创建好本地视频 Track 后即可设置预览窗口,代码如下:\n\n \n \n [cameraVideoTrack play:localPreview];\n \n\n> **注意** :创建 Track 需要 App 获取设备摄像头、麦克风采集相关的权限,请确保您的应用已经获取该权限,否则数据采集将会失败,可参考\n> [API-Examples-iOS](https://github.com/pili-engineering/QNRTC-\n> iOS/blob/master/QNRTC-API-Examples/Api-Examples-iOS/Info.plist) 实现。\n\n# 加入房间\n\n完成初始化以及本地音视频 Track 创建后,就可以调用\n[QNRTCClient.join](https://developer.qiniu.com/rtc/api/8836/QNRTCClient-\niOS#join%5B1/2%5D) 加入房间了。\n\n> 加入房间需要携带 [RoomToken](https://developer.qiniu.com/rtc/quick_start/9909/the-\n> rtc-basic-concept#room_token)\n>\n> 1. [RoomToken](https://developer.qiniu.com/rtc/quick_start/9909/the-rtc-\n> basic-concept#room_token) 建议通过您的服务端生成,签算方式可参考 [RoomToken\n> 签发服务](https://developer.qiniu.com/rtc/8813/roomToken)\n> 2.\n> 若您的服务端还没有实现相关代码,可参考[管理实时音视频](https://developer.qiniu.com/rtc/9858/applist#4)文档在\n> [portal](https://portal.qiniu.com/app) 上生成临时的 Token,需要注意 **UserID不可重复** 。\n>\n\n示例代码如下:\n\n \n \n [rtcClient join:token];\n \n\n加入房间成功后会触发\n[QNRTCClientDelegate.didConnectionStateChanged](https://developer.qiniu.com/rtc/api/9248/QNRTCClientDelegate#didConnectionStateChanged)\n回调 [QNConnectionStateConnected](https://developer.qiniu.com/rtc/9255/quick-\nstart-iOS/9254) 状态。此时,可通过发布、订阅等操作来实现音视频的推送和接收。\n\n在进入音视频通话房间之后,用户可以根据业务场景的需求,在适当的时间调用离开房间的接口退出连麦,详情请见[房间管理](https://developer.qiniu.com/rtc/development_guidelines/9261/room-\nmanagement-iOS)。\n\n> **注意** :加入、离开房间代表一次音视频通话的开始和结束,一次会话仅需调用一次加入、离开的操作即可,无需重复调用。\n\n# 发布本地音视频 Track\n\n成功加入房间后,即可在\n[QNRTCClientDelegate.didConnectionStateChanged](https://developer.qiniu.com/rtc/api/9248/QNRTCClientDelegate#didConnectionStateChanged)\n回调中调用以下代码进行本地 Track 的发布:\n\n \n \n - (void)RTCClient:(QNRTCClient *)client didConnectionStateChanged:(QNConnectionState)state disconnectedInfo:(QNConnectionDisconnectedInfo *)info {\n dispatch_async(dispatch_get_main_queue(), ^{ \n if (QNConnectionStateConnected == state) {\n [self.client publish:@[cameraVideoTrack, microphoneAudioTrack] completeCallback:^(BOOL onPublished, NSError *error) {\n if (onPublished) {\n \t// 发布成功了\n } else {\n \t// 发布失败了\n }\n }];\n } \n });\n }\n \n\n发布成功后,本地通过\n[QNPublishResultCallback.onPublished](https://developer.qiniu.com/rtc/api/9254/QNTypeDefines#QNPublishResultCallback)\n获得发布成功的结果。而远端用户则会收到\n[QNRTCClientDelegate.didUserPublishTracks](https://developer.qiniu.com/rtc/api/9248/QNRTCClientDelegate#didUserPublishTracks)\n发布成功的回调。\n\n在成功发布之后,用户可以根据业务场景的需求,在适当的时间调用取消发布的接口\n[QNRTCClient.unpublish](https://developer.qiniu.com/rtc/api/8836/QNRTCClient-\niOS#unpublish),取消发布相应的\nTrack,详情请见[发布与订阅](https://developer.qiniu.com/rtc/development_guidelines/8769/publish-\nand-subscribe-iOS)。\n\n# 订阅远端音视频 Track\n\n当远端成功发布音视频数据后,SDK 默认会进行自动订阅,订阅成功后将会收到\n[QNRTCClientDelegate.didSubscribedRemoteVideoTracks](https://developer.qiniu.com/rtc/api/9248/QNRTCClientDelegate#didSubscribedRemoteVideoTracks)\n的回调,此时在回调内部渲染显示远端窗口:\n\n \n \n - (void)RTCClient:(QNRTCClient *)client didSubscribedRemoteVideoTracks:(NSArray<QNRemoteVideoTrack *> *)videoTracks audioTracks:(NSArray<QNRemoteAudioTrack *> *)audioTracks ofUserID:(NSString *)userID {\n dispatch_async(dispatch_get_main_queue(), ^{\n for (QNRemoteVideoTrack * videoTrack in videoTracks) {\n [videoTrack play:remoteView];\n }\n });\n }\n \n\n在成功订阅之后,用户可以根据业务场景的需求,在适当的时间调用取消订阅的接口\n[QNRTCClient.unsubscribe](https://developer.qiniu.com/rtc/api/8836/QNRTCClient-\niOS#unsubscribe),取消订阅相应的\nTrack,详情请见[发布与订阅](https://developer.qiniu.com/rtc/development_guidelines/8769/publish-\nand-subscribe-iOS)。\n\n# 离开房间\n\n当音视频通话结束,调用以下代码离开房间:\n\n \n \n [self.client leave];\n \n\n> **注意** :离开房间代表本地音视频通话的结束,将无法发布本地音视频,也无法订阅远端音视频。\n\n# 销毁\n\n在整个 viewController 销毁时,用户需要调用以下代码对资源进行释放,一般此操作建议在 viewController 生命周期的\n`dealloc` 之前进行,示例代码如下:\n\n \n \n - (void)viewDidDisappear:(BOOL)animated {\n [QNRTC deinit];\n [super viewDidDisappear:animated];\n }\n \n\n# 示例代码\n\n按照上述流程即可实现一个基本的实时音视频通话应用,完整的示例代码可参考 [API-Examples-\niOS](https://github.com/pili-engineering/QNRTC-iOS/blob/master/QNRTC-API-\nExamples/Api-Examples-iOS/Module/Video/CameraVideo/CameraVideoExample.m)。\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频SDK 概览"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Web >SDK 概览\n\n# SDK 概览\n\n最近更新时间: 2024-06-20 19:23:04\n\n# SDK 介绍\n\n这是一款适用于 Web 平台的七牛实时音视频 SDK,提供了包括音视频通话、静音、发布、订阅等多种功能,基于此 SDK,您可以很方便地在 Web\n上开发出一款基于实时音视频的应用。 \n其中包括但不限于以下场景\n\n * 在线教育\n * 主播观众连麦\n * 视频会议\n * 一对一社交\n * 狼人杀等依赖实时音视频通话的游戏\n * 在线客服\n * 在线抓娃娃\n\n您可以访问 [Demo页面](https://demo-rtc.qiniuapi.com) ,体验我们最新的 Demo 效果。(请使用最新版 Chrome\n浏览器)\n\n# SDK 功能列表\n\n以下是 SDK 截止到最新版本所提供的功能列表\n\n功能| 版本 \n---|--- \n基本的音视频通话功能| v0.1.0 \n支持内置音视频采集| v0.1.0 \n支持 Typescript| v0.1.0 \n支持踢人功能| v0.1.0 \n支持静音功能| v0.1.0 \n支持帧率配置| v0.1.0 \n支持视频尺寸配置| v0.1.0 \n支持自动重连| v0.1.0 \n支持丰富的消息回调| v0.1.0 \n支持音视频码率的配置| v0.1.1 \n支持 USB 外置媒体设备| v0.1.1 \n支持配置服务端合流| v0.2.0 \n支持本地音视频采集数据的回调| v0.2.0 \n支持远端音视频渲染数据的回调| v0.2.0 \n支持主流浏览器| v1.0.0 \n支持屏幕/窗口分享| v1.0.0 \n支持外部音频导入| v1.0.0 \n支持单用户多流的场景| v2.0.0 \n支持动态订阅| v2.0.0 \n支持录制屏幕捕获声音| v2.3.0 \n支持发送文本消息| v2.3.0 \n支持视频大小流| v2.3.1 \n支持 Safari 屏幕共享| v2.4.1 \n支持切换图片 track| v2.4.1 \n \n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频开发准备"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Web >开发准备\n\n# 开发准备\n\n最近更新时间: 2022-06-08 16:46:46\n\n# 接入之前\n\n> **浏览器只允许 localhost 或者 https 页面访问媒体设备(摄像头等),请先检查确保在该环境下运行 SDK。**\n\n# 接入流程\n\n在开始编写代码之前,请先确认您已经对这个产品有了大概的了解,并且已经完成了\n[七牛实时音视频云接入流程](https://developer.qiniu.com/rtc/10155/process)。\n\n> 当您已经可以随时生成实时音视频云的 RoomToken 时(在控制台手动生成,或者调用后端生成都可以), 就认为完成了接入流程,可以准备开发工作了\n\n# 引入 SDK\n\n我们提供了两种方式引入方式,您可以直接下载 JS 文件,也可以通过 `npm` 完成引入\n\n## NPM 安装\n\n运行下方的命令即可通过 `npm` 引入我们的 SDK\n\n \n \n npm install --save qnweb-rtc\n \n\n如果想要更新到最新版本或者指定版本,运行下列命令\n\n \n \n npm install --save qnweb-rtc@latest # 最新版本\n npm install --save [email protected] # 指定版本\n \n\n> 我们更加推荐您使用 [yarn](https://yarnpkg.com/zh-Hans/) 来管理 npm 模块 \n> 通过 `yarn add qnweb-rtc` 引入 SDK,通过 `yarn add qnweb-rtc@latest` 来更新版本\n\n安装好后,运行以下代码访问 SDK 的入口\n\n \n \n import QNRTC from \"qnweb-rtc\";\n \n console.log(\"current version is\", QNRTC.VERSION);\n \n\n运行时看到打印的 `current version` 表示引入成功\n\n> 注意!我们默认提供的是 **没有 polyfill** 的 [ECMAScript 5](https://www.ecma-\n> international.org/ecma-262/5.1/) 代码。\n\n## 直接导入 JS 文件\n\n每次发布版本,我们都会将最新的 SDK JS 文件放在我们的 [Github](https://github.com/pili-\nengineering/QNRTC-Web/blob/master/Release/qnweb-rtc.js) 上,点击链接即可获取当前最新的 SDK JS\n文件。 所以,每次想要升级版本时,只需要访问我们的 [Github](https://github.com/pili-engineering/QNRTC-\nWeb/blob/master/Release/qnweb-rtc.js) 页面,然后替换一下自己的 js 文件即可。\n\n> 如果想要使用特定版本的 SDK,可以访问我们 Github 的 [Release](https://github.com/pili-\n> engineering/QNRTC-Web/releases) 页面查看。\n\nSDK 的 JS 文件在导入页面后,会自动创建一个全局对象 `QNRTC`,这个对象的成员包括了 SDK 所导出的所有模块和对象。\n\n \n \n // 当页面资源加载完成后\n window.onload = () => {\n console.log(\"current version is\", QNRTC.VERSION);\n }\n \n\n运行时看到打印的 `current version` 表示引入成功。\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频实现视频通话"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Web >实现视频通话\n\n# 实现视频通话\n\n最近更新时间: 2022-07-14 15:44:44\n\n如果您已经完成了上文中提到的开发准备,现在就让我们开始编写一个基本的实时音视频应用吧。这个应用会展示 SDK 基本的连麦功能,包括\n加入房间,采集,发布,订阅 等过程。但是在实际的连麦应用开发过程中,是需要后端介入的(用于给用户鉴权并生成\nRoomToken),在这里为了减少开发的时间,请您先预先生成 2 个 RoomToken(要求同一个 APPID,同一个 RoomName,不同的\nUserName)。\n\n> 如果您还不知道如何生成 RoomToken,请先阅读\n> [七牛实时音视频云接入指南](https://developer.qiniu.com/rtc/8813/roomToken)\n\n下文代码中的 `ROOMTOKEN_1` 和 `ROOMTOKEN_2` 表示生成的两个RoomToken。 \n我们将会编写 1 个独立的 `html` 页面,主要包括采集本地的摄像头/麦克风数据并将其发布与订阅发布流并将其展示在页面上的功能。\n\n> 您可以从 [这里](https://github.com/pili-engineering/QNRTC-SampleCode-Video-\n> Basic/tree/master/One-On-One-Video/One-On-One-Video-Web/native) 查看这个 Demo\n> 最终的成品代码,但是还是建议您在按照步骤阅读完之后再参阅。\n\n# 引入 SDK 并准备页面\n\n如果一切准备就绪,让我们开始吧,首先创建一个 `oneOnOne.html` 文件。\n\n \n \n <!DOCTYPE html>\n <html>\n <head>\n <meta charset=\"utf-8\" />\n <title>One on One Sample</title>\n <script src=\"https://docs.qnsdk.com/qnweb-rtc.js\"></script>\n <style>\n #localtracks, #remotetracks {\n width: 320px;\n height: 240px;\n background: #000;\n }\n </style>\n </head>\n <body>\n <label>请输入 RoomToken 加入房间开始连麦</label>\n <input id=\"roomtoken\" type=\"text\" />\n <button onclick=\"joinRoom()\">加入房间</button>\n <p>本地视频</p>\n <div id=\"localtracks\"></div>\n <p>远端视频</p>\n <div id=\"remotetracks\"></div>\n </body>\n </html>\n \n\n> **<https://docs.qnsdk.com/qnweb-rtc.js> 该链接仅供测试,正式环境需要自行准备 JS 文件或自行 NPM\n> 下载。JS SDK 文件 放在我们的 [Github](https://github.com/pili-engineering/QNRTC-\n> Web/blob/master/Release/qnweb-rtc.js) 上,只需要访问我们的\n> [Github](https://github.com/pili-engineering/QNRTC-\n> Web/blob/master/Release/qnweb-rtc.js) 页面,然后替换一下自己的 js 文件即可。**\n\n然后在项目的目录下起一个 `http` 服务,打开 Chrome 通过 `localhost` 或者 `127.0.0.1` 访问刚刚那 2\n个页面(因为屏幕和摄像头采集只能在 `localhost` 或者 `https` 下完成), 观察到控制台打印出了 sdk 的版本信息说明这一步完成了。\n\n> 如果您不知道如何在本地起一个 `http` 服务,推荐使用基于 nodejs 的 [http-\n> server](https://github.com/indexzero/http-\n> server)。可以参考[这篇文章](http://www.cnblogs.com/xing901022/p/4286273.html)。\n\n> 注意!Chrome 只允许 `localhost` 或者 `https` 的网络页面访问媒体设备。请在之后的开发和上线中注意这一点\n\n# 加入房间\n\n上文提到过,SDK 所有的功能都是从 `RoomToken` 开始的,所以加入房间只需要将 `RoomToken` 作为参数传给 SDK 就可以了。编辑\n`html` 在 `<script>` 中添加如下代码。\n\n \n \n // 确认引入成功\n console.log(\"current version\", QNRTC.VERSION);\n // 这里采用的是 async/await 的异步方案,您也可以根据需要或者习惯替换成 Promise 的写法\n async function joinRoom() {\n // 创建QNRTCClient对象\n const client = QNRTC.createClient();\n const roomTokenInput = document.getElementById(\"roomtoken\");\n const roomToken = roomTokenInput.value;\n // 这里替换成刚刚生成的 RoomToken\n await client.join(roomToken);\n console.log(\"joinRoom success!\");\n }\n \n\n再次访问这个页面,输入 `ROOMTOKEN_1` 点击加入房间按钮,看到控制台打印出 `joinRoom success!` 表示这一步完成。\n\n# 采集并发布本地的音视频轨\n\n接下来,我们的任务是在 `html` 下采集本地的媒体数据并把它发布到房间中。在编写代码之前,请先确认您的电脑已经连接了摄像头和麦克风设备(支持 USB\n设备)。\n\n> 如果没有摄像头或者没有麦克风(缺少其中一个),请稍微修改下文中的采集参数关闭音频或者视频采集\n\n这里我们将要采集 2 个音视频轨,分别是 `摄像头视频轨` 和 `麦克风音频轨`。\n\n编辑 `html` 中的 `<script>`,添加如下代码。\n\n \n \n // 增加一个函数 publish,用于采集并发布自己的媒体流\n // 这里的参数 client 是指刚刚初始化的 QNRTCClient 对象\n async function publish(client) {\n // 同时采集麦克风音频和摄像头视频轨道。\n // 这个函数会返回一组audio track 与 video track\n const localTracks = await QNRTC.createMicrophoneAndCameraTracks();\n console.log(\"my local tracks\", localTracks);\n // 将刚刚的 Track 列表发布到房间中\n await client.publish(localTracks);\n console.log(\"publish success!\");\n }\n \n\n这个函数很简单,主要就 2 个语句,我们现在仔细分析一下这 2 行代码分别做了什么。 \n第一句,调用了 QNRTC 提供的静态方法 `createMicrophoneAndCameraTracks`\n,从名字我们可以看出,这个方法负责采集本地的麦克风频轨与摄像头轨道,并将其包装成 SDK 的 `Track` 对象并以列表的形式返回给我我们。\n\n第二句,调用了 QNRTCClient 提供的方法 `publish` ,将本地 `Track` 发布至远端。\n\n然后在刚刚 `joinRoom` 的函数末尾调用我们刚刚编写的 `publish`\n\n \n \n async function joinRoom() {\n // 创建QNRTCClient对象\n const client = QNRTC.createClient();\n const roomTokenInput = document.getElementById(\"roomtoken\");\n const roomToken = roomTokenInput.value;\n // 这里替换成刚刚生成的 RoomToken\n await client.join(roomToken);\n console.log(\"joinRoom success!\");\n await publish(client);\n }\n \n\n现在访问页面,加入房间后 Chrome 应该会申请媒体设备的权限,同意之后观察控制台打印出 `publish success!` 表示发布成功。 \n如果您有需要想要看到自己刚刚采集的视频画面,可以在 `publish` 函数的末尾添加如下代码\n\n \n \n ...\n ...\n await client.publish(localTracks);\n console.log(\"publish success!\");\n \n // 在这里添加\n // 获取页面上的一个元素作为播放画面的父元素\n const localElement = document.getElementById(\"localtracks\");\n // 遍历本地采集的 Track 对象\n for (const localTrack of localTracks) {\n console.log(localTrack)\n // 如果这是麦克风采集的音频 Track,我们就不播放它。\n if (localTrack.isAudio()) continue;\n // 调用 Track 对象的 play 方法在这个元素下播放视频轨\n localTrack.play(localElement, {\n mirror: true\n });\n }\n \n\n下一步,我们将在 `html` 中完成订阅的代码,实现对我们刚刚发布的音视频轨道的订阅。\n\n# 订阅远端发布的音视频轨\n\n从上文发布的过程中我们可以知道,一个用户可以发布多个 `Track` ,而在实际需求中我们不一定会把他所有发布的 Track\n都订阅(可能只订阅音频之类的),所以订阅的目标是以 `Track` 为单位的。 \n那么,我怎么知道房间中有哪些 `Track` ,这些 `Track` 又分别对应哪些用户呢?这就是我们接下来讲述的重点。\n\n我们可以通过 SDK 的 `user-published` 事件获取当前房间的 `Track` 列表:\n\n> 需要在join房间之前监听对应事件,`join` 加入房间成功后,`user-published` 会返回当前所有房间内已发布 `Track`\n> 列表以及用户 `userID` 。\n\n进入房间后,当一个远端用户发布了自己的 `Track` ,此时在我们这边也会触发 `user-published` 事件,事件会带上远端用户的\n`userID` 以及所发布的 `Track` 列表。\n\n具体让我们通过代码来理解,在 `oneOnOne.html` 的 `<script>` 中添加函数 `subscribe` 和\n`autoSubscribe`, `subscribe` 用于传入 TrackInfo 完成订阅操作并播放订阅流,`autoSubscribe`\n用于实时检测房间的 TrackInfo 变化并在合适的时机调用 `subscribe`。\n\n \n \n // 这里的参数 client 是指刚刚初始化的 QNRTCClient 对象\n async function subscribe(client, tracks) {\n // 传入 Track 对象数组调用订阅方法发起订阅,异步返回成功订阅的 Track 对象。\n const remoteTracks = await client.subscribe(tracks);\n \n // 选择页面上的一个元素作为父元素,播放远端的音视频轨\n const remoteElement = document.getElementById(\"remotetracks\");\n // 遍历返回的远端 Track,调用 play 方法完成在页面上的播放\n for (const remoteTrack of [...remoteTracks.videoTracks, ...remoteTracks.audioTracks]) {\n remoteTrack.play(remoteElement);\n }\n }\n \n\n> 在一次批量订阅中,如果想区分返回的 Track(比如播放屏幕分享的 `Track` 时给更大的界面),和上文一样,通过 tag 来区分。这里的 tag\n> 来自于远端采集它的时候所指定的 tag。\n\n代码不多,总共就两步。先是发起订阅拿到返回的 `Track` 对象,之后调用 `Track` 的 play 方法在页面上播放。 \n下面我们实现 `autoSubscribe` 将 `TrackInfo` 传给 `subscribe`。\n\n \n \n // 这里的参数 client 是指刚刚初始化的 QNRTCClient 对象, 同上\n function autoSubscribe(client) {\n // 添加事件监听,当房间中出现新的 Track 时就会触发,参数是 trackInfo 列表\n client.on(\"user-published\", (userId,tracks) => {\n console.log(\"user-published!\", userId,tracks);\n subscribe(client, tracks)\n .then(() => console.log(\"subscribe success!\"))\n .catch(e => console.error(\"subscribe error\", e));\n });\n // 就是这样,就像监听 DOM 事件一样通过 on 方法监听相应的事件并给出处理函数即可\n }\n \n\n最后,让我们在 `html` 的 `joinRoom` 中调用 `autoSubscribe` 即可\n\n \n \n async function joinRoom() {\n // 创建QNRTCClient对象\n const client = QNRTC.createClient();\n // 需要先监听对应事件再加入房间\n autoSubscribe(client);\n const roomTokenInput = document.getElementById(\"roomtoken\");\n const roomToken = roomTokenInput.value;\n // 这里替换成刚刚生成的 RoomToken\n await client.join(roomToken);\n console.log(\"joinRoom success!\");\n await publish(client);\n }\n \n\n好啦,这个时候再访问这个页面,使用两个不同的 `RoomToken` 分别进入房间中,在 `html`\n中看到你自己和屏幕的画面就代表成功啦。您成功完成了一个最简单的一对一连麦应用(而且还支持单用户多流)。\n\n## 接下来...\n\n经过上面的步骤之后,相信您已经对一次连麦互动的流程以及 SDK 的使用有了大概的了解。如果您已经准备正式开始接入我们的 SDK,下面一些建议可以让您更加熟悉\nSDK。\n\n * SDK 使用中每个功能的细节都可以通过左侧的功能列表去查看\n * 如果您想了解 SDK 的架构以及所暴露的模块细节,可以阅读 [API 文档](https://developer.qiniu.com/rtc/9246/WEB%20API%20%E6%A6%82%E8%A7%88) 。\n\n> 如果您在使用过程中遇到什么疑问,或者遇到了 BUG,请在 Github 的 [issue](https://github.com/pili-\n> engineering/QNRTC-Web/issues) 列表提问,我们会尽快为您解答。\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频浏览器兼容性说明"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Web >浏览器兼容性说明\n\n# 浏览器兼容性说明\n\n最近更新时间: 2022-01-05 15:25:02\n\n# 概述\n\nWebRTC 是一个支持网页浏览器进行实时语音对话或视频对话、进行实时数据传输的一组 JavaScript API。\n\n七牛 RTC Web SDK 使用了 WebRTC 技术实现实时音视频功能。因此,SDK 是否可用,依赖于当前浏览器对 WebRTC API\n的支持情况。目前 WebRTC 主要在桌面端的 Chrome、 Firefox️、Safari 等浏览器,以及移动端的 Safari\n浏览器上有较为完整的支持。本文将分别介绍桌面端和移动端的浏览器兼容性情况。\n\n> 由于平台和一些应用内置浏览器的实现各不相同,无法涵盖所有浏览器,因此在通话前建议先对浏览器兼容性支持情况做检测,具体检测方法参考\n> [浏览器兼容性检测](https://developer.qiniu.com/rtc/10232/check-system-requirements)。\n\n# 桌面浏览器\n\n目前七牛 RTC Web SDK在桌面端支持的浏览器及版本如下:\n\n> 当前桌面浏览器中,Chrome 对 WebRTC API 的支持情况最好,建议使用最新版本的 Chrome 浏览器。\n\n操作系统 | 浏览器 | 版本兼容性 | 拉流 | 推流 | 屏幕共享 \n---|---|---|---|---|--- \nMacOS | Safari 浏览器 | 11.0 或以上版本 | ✔️ | ✔️ | ✔️(Safari 13 或以上版本支持) \nChrome 浏览器 | 56.0 或以上版本 | ✔️ | ✔️ | ✔️(Chrome 72 或以上版本支持) \nFirefox 浏览器 | 56.0 或以上版本 | ✔️ | ✔️ | ✔️(Firefox 66或以上版本支持) \nEdge 浏览器 | 80 或以上版本 | ✔️ | ✔️ | ✔️ \n微信内置浏览器 | —— | ✔️ | ✔️ | ✖️ \n \nWindows \n \n \n \n| Chrome 浏览器 | 56 或以上版本 | ✔️ | ✔️ | ✔️(Chrome 72 或以上版本支持) \nFirefox 浏览器 | 56 或以上版本 | ✔️ | ✔️ | ✔️(Firefox 66 或以上版本支持) \nQQ浏览器 | 10.4 或以上版本 | ✔️ | ✔️ | ✖️ \nEdge 浏览器 | 80或以上版本支持 | ✔️ | ✔️ | ✔️ \n微信内置浏览器 | —— | ✔️ | ✖️ | ✖️ \n \n# 移动浏览器\n\n## Android\n\n目前七牛 RTC Web SDK 在 Android 上支持的浏览器情况如下:\n\n操作系统 | 浏览器 | 拉流 | 推流 | 屏幕共享 \n---|---|---|---|--- \n \n \nAndroid \n \n \n| Chrome浏览器 | ✔️ | ✔️ | ✖️ \nUC 浏览器(不支持) | ✖️ | ✖️ | ✖️ \nFirefox 浏览器 | ✔️ | ✔️ | ✖️ \nQQ 浏览器 | ✔️ | ✔️ | ✖️ \n企业微信浏览器 | ✔️ | ✔️ | ✖️ \n微信内置浏览器 (X5内核) | ✔️ | ✔️ | ✖️ \n \n> 以上列表中提供的浏览器可以大致表明兼容性情况,但由于Android\n> 设备上浏览器情况比较复杂,不同手机产商对自带浏览器内核或多或少做出改动,所以无法保证自带浏览器能够很好地支持 WebRTC,建议开发者使用 Chrome\n> 浏览器。\n>\n> 也可结合上面提到的[浏览器兼容性检测](https://developer.qiniu.com/rtc/10232/check-system-\n> requirements)方法,在使用之前先进行检测,通过测试之后再允许用户使用。\n\n## iOS\n\n目前七牛 RTC Web SDK 在 iOS 上支持的浏览器情况如下:\n\n操作系统 | 浏览器 | 版本兼容性 | 拉流 | 推流 | 屏幕共享 \n---|---|---|---|---|--- \n操作系统 | 浏览器 | 版本兼容性 | 拉流 | 推流 | 屏幕共享 \niOS 11.0.1 或以上版本 | Safari浏览器 | 11.0 或以上版本 | ✔️ | ✔️ | ✖️ \niOS 12.1.4 或以上版本 | Chrome 浏览器 | —— | ✔️ | ✖️ | ✖️ \niOS 12.1.4 或以上版本 | Edge浏览器 | —— | ✔️ | ✖️ | ✖️ \niOS 12.1.4 或以上版本 | 微信内置浏览器 | —— | ✔️ | ✖️ | ✖️ \niOS 12.1.4 或以上版本 | 企业微信内置浏览器 | —— | ✔️ | ✖️ | ✖️ \niOS 14.3 或以上版本 | Chrome 浏览器 | —— | ✔️ | ✔️ | ✖️ \niOS 14.3 或以上版本 | 微信内置浏览器 | 推荐最新版本 | ✔️ | ✔️ | ✖️ \niOS 14.3 或以上版本 | Edge 浏览器 | —— | ✔️ | ✔️ | ✖️ \n \n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频SDK 概览"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Windows >SDK 概览\n\n# SDK 概览\n\n最近更新时间: 2022-11-11 16:42:29\n\n## 概述\n\nQNRTCWin 是七牛云推出的一款适用于 Win7 及以上版本 Windows 平台的实时音视频 C++\nSDK,提供了灵活的接口,支持高度定制以及二次开发。\n\n## 场景介绍\n\nQNRTCWin 适用于一对一、一对多、多对多的实时语音聊天、唱歌、教学、医疗等场景,同时可与其它平台 Android、iOS、Web、Linux\n等平台互通。\n\n## 下载地址\n\n * [Windows Demo 以及 SDK 下载地址](https://github.com/pili-engineering/QNRTC-Windows)\n\n## 功能列表\n\n功能| 版本 \n---|--- \n增加 Intel 和 Nvidia 硬件编码功能| v3.1.0(+) \n支持对 D3D 窗口的捕获能力| v3.1.0(+) \nsei 支持 uuid 设置| v3.1.0(+) \n桌面共享支持帧率设置| v3.1.0(+) \n合流支持停止时保持最后一帧功能| v3.0.2(+) \n增加单路转推成功的回调| v3.0.2(+) \n支持摄像头切换图片连麦| v3.0.1(+) \n支持添加自定义SEI 功能| v3.0.1(+) \n支持合流时单独设置 Track 填充模式| v3.0.1(+) \n支持设置渲染窗口画面填充模式| v3.0.1(+) \n支持对外部视频进行裁剪和缩放功能| v3.0.1(+) \n支持摄像头采集数据镜像功能| v3.0.1(+) \n增加远端用户重连中/重连成功消息通知| v3.0.0(+) \n增加音频加解密功能| v3.0.0(+) \n增加 dns 域名解析功能| v3.0.0(+) \n增加是否开启 qos 信息回调的接口| v3.0.0(+) \n增加单路转推是否为内部推流设置| v3.0.0(+) \n新增大小流功能| v2.4.0(+) \n新增单路转推功能| v2.4.0(+) \n新增收发自定义消息功能| v2.3.0(+) \n新增画面旋转功能| v2.3.0(+) \n摄像头采集画面新增裁剪和缩放的功能| v2.3.0(+) \n添加对端网络信令回调字段:远端用户 track 丢包率,远端用户 rtt| v2.3.0(+) \n添加本地统计回调字段:本地 rtt| v2.3.0(+) \n新增 unpublish 的回调| v2.3.0(+) \n新增创建自定义合流任务功能| v2.2.0(+) \n新增对外部编解码器的支持| v2.1.0(+) \n新增回声消除的动态开关| v2.1.0(+) \n新增 64bit 版本的支持| v2.1.0(+) \n新增媒体传输策略配置| v2.1.0(+) \n支持同时订阅多路视频 Track| v2.0.0(+) \n支持 I420 视频数据的剪裁| v1.1.0(+) \n支持其它原始数据格式转换为 I420 格式| v1.1.0(+) \n支持外部音频数据导入| v1.0.0(+) \n支持外部视频数据导入| v1.0.0(+) \n支持屏幕、窗口的采集| v1.0.0(+) \n支持视频渲染镜像功能| v1.0.0(+) \n基本的音视频通话功能| v0.2.0(+) \n支持纯音频通话| v0.2.0(+) \n支持物理和虚拟摄像头采集| v0.2.0(+) \n支持踢人功能| v0.2.0(+) \n支持音频调节功能| v0.2.0(+) \n支持视频帧率配置| v0.2.0(+) \n支持视频码率的配置| v0.2.0(+) \n支持视频尺寸配置| v0.2.0(+) \n支持网络自动重连| v0.2.0(+) \n支持获取通话质量统计信息| v0.2.0(+) \n支持房间状态回调| v0.2.0(+) \n支持本地音视频采集数据的回调| v0.2.0(+) \n支持远端音视频渲染数据的回调| v0.2.0(+) \n支持音视频设备插拔事件的回调| v0.2.0(+) \n \n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频开发准备"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Windows >开发准备\n\n# 开发准备\n\n最近更新时间: 2022-11-11 16:42:47\n\n## 开发语言以及系统要求\n\n * 开发语言:C++14\n * 系统要求:Windows 7 及以上版本的 Windows 系统\n\n## 开发环境\n\n * [Visual Studio 2017](https://www.visualstudio.com/zh-hans/vs/older-downloads/) 或 [Qt Creator](http://download.qt.io/archive/qt/)\n * Windows Platform\n\n## 导入 SDK\n\n将下载好的 SDK 拷贝到你的工程目录中 `$(ProjectDir)`,添加 `$(ProjectDir)Release\\include`\n到头文件引用目录,添加 `$(ProjectDir)Release\\lib` 到依赖库查找目录中,并拷贝 `QNRtcStreaming.dll`\n工程运行目录下,然后在代码中通过静态加载的方式加载 SDK 库,如下:\n\n \n \n #include \"QNRTCClientInterface.h\"\n #include \"QNRTCInterface.h\"\n #include \"QNTrackInterface.h\"\n #include \"QNErrorCode.h\"\n \n using namespace qiniu_v2;\n \n #pragma comment(lib, \"QNRtcStreaming.lib\")\n \n\n## 编译运行\n\n编译运行,验证以上配置是否正确,如果运行时提示缺少\n`XXX.dll`,则说明以上目录配置错误,需再检查下目录配置,以及动态库是否被拷贝至应用程序的工作目录。\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频实现视频通话"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Windows >实现视频通话\n\n# 实现视频通话\n\n最近更新时间: 2022-03-24 16:34:11\n\n## 初始化\n\n首先配置 SDK 日志输出等级和存储位置:\n\n \n \n // 在程序初始化时调用此方法初始化 SDK log 配置,不调用 == 无输出\n QNRTC::SetLogFile(qiniu::kLogInfo, \"rtc-log\", \"rtc.log\");\n \n\n> 注:SDK log 输出每次以覆盖的方式写入文件,超过 100M 覆盖,中途没有文件大小及磁盘剩余空间的检测。\n\n * 创建音视频通话核心类(全局唯一):\n\n \n \n // 初始化全局参数,这里根据自己的需要设置相应参数\n QNRTCSetting setting;\n QNRTC::Init(setting, this);\n // 释放时调用 QNRTC::DestroyRtcClient 方法接口\n QNRTCClient* rtc_client_ptr_ = QNRTC::CreateClient(this);\n \n\n## 创建 Track:\n\nTrack 代表了音视频通话过程中的一路音频或者一路视频,本文仅介绍一路音视频连麦的场景,创建方式如下:\n\n \n \n QNCameraVideoTrackConfig camera_info = {{width, height, 30, 2000},\n {width, height, 30},\n video_dev_id,\n CAMERA_TAG,\n enable_simulcast_};\n QNCameraVideoTrack* camera_track_ptr = QNRTC::CreateCameraVideoTrack(camera_info, this);\n \n QNMicrophoneAudioTrackConfig micro_info = {{0, 0, 0, 32}, MICROPHONE_TAG};\n QNMicrophoneAudioTrack* microphone_audio_track_ptr =\n QNRTC::CreateMicrophoneAudioTrack(micro_info);\n \n\n## 枚举视频采集设备\n\n获取本地视频采集设备数量,以及其所支持的采集参数:\n\n \n \n // 获取本地视频采集设备数量\n int camera_count = QNRTC::GetCameraCount();\n // 枚举所有设备列表,及其所支持的采集参数,key:device id value:CameraDeviceInfo\n unordered_map<string, CameraDeviceInfo> camera_dev_map_; \n for (int i(0); i < camera_count; ++i) {\n \tCameraDeviceInfo ci = QNRTC::GetCameraInfo(i);\n \tcamera_dev_map_[ci.id] = ci;\n }\n \n\n## 加入房间\n\n上文提到过,SDK 所有的功能都是从 `RoomToken` 开始的,所以加入房间只需要将 `RoomToken` 作为参数传给 SDK\n就可以了。示例代码如下:\n\n \n \n rtc_client_ptr_->Join(_room_token);\n \n\n加入房间成功后会触发\n[QNClientEventListener.OnConnectionStateChanged](https://developer.qiniu.com/rtc/api/9407/QNClientEventListener#OnConnectionStateChanged)\n回调 QNConnectionState.CONNECTED 状态。此时即可进行发布、订阅等操作。\n\n在进入音视频通话房间之后,用户可以根据业务场景的需求在适当的时间调用离开房间的接口退出连麦,详情请见[房间管理](https://developer.qiniu.com/rtc/development_guidelines/9547/room-\nmanagement-windows)。\n\n> 注:此处 `_room_token` 建议开发者的应用程序从自己的 Server 端获取,关于 Server 如何生成 token\n> 可查阅[服务端开发文档](https://developer.qiniu.com/rtn/sdk/4538/server-api-\n> reference#5)。\n\n## 发布音/视频\n\n成功加入房间后,即可在\n[QNClientEventListener.OnConnectionStateChanged](https://developer.qiniu.com/rtc/api/9407/QNClientEventListener#OnConnectionStateChanged)\n回调中调用以下代码进行本地 Track 的发布:\n\n \n \n void CRtcDemoV2::OnConnectionStateChanged(qiniu::QNConnectionState state, const qiniu::QNConnectionDisconnectedInfo& info)\n {\n if (state == CONNECTED) {\n StartPublish();\n }\n }\n \n\n发布成功后,本地会收到\n[QNPublishResultCallback.OnPublished](https://developer.qiniu.com/rtc/api/9435/QNPublishResultCallback#OnPublished)\n回调。远端用户会收到\n[QNClientEventListener.OnUserPublished](https://developer.qiniu.com/rtc/api/9407/QNClientEventListener#OnUserPublished)\n回调。\n\n## 订阅远端音/视频\n\nSDK 收到远端发布\n[QNClientEventListener.OnUserPublished](https://developer.qiniu.com/rtc/api/9407/QNClientEventListener#OnUserPublished)\n的回调,在此回调内则可进行对 Track 的渲染窗口设置的操作,再进行订阅,如果用户默认设置了自动订阅,这里只需设置渲染窗口,不需要主动去订阅:\n\n注:用于渲染视频的窗口句柄,在 MFC 中直接使用窗口类的 m_hWnd 成员变量获取,Qt 中通过窗口类的 winId() 方法进行获取,。\n\n在成功订阅之后,用户可以根据业务场景的需求在适当的时间调用取消订阅的接口取消订阅相应的\nTrack,详情请见[发布与订阅](https://developer.qiniu.com/rtc/development_guidelines/9548/publish-\nand-subscribe-windows)\n\n## 离开房间\n\n当音视频通话结束,调用以下代码离开房间:\n\n \n \n rtc_client_ptr_->Leave();\n \n\n## 销毁\n\n用户需要调用以下代码对资源进行释放,一般此操作建议在程序生命周期的 `OnDestroy()` 中进行,示例代码如下:\n\n \n \n if (rtc_client_ptr_) {\n rtc_client_ptr_->Leave();\n }\n \n if (camera_track_ptr_) {\n QNRTC::DestroyLocalTrack(camera_track_ptr_);\n camera_track_ptr_ = nullptr;\n }\n \n if (screen_track_ptr_) {\n QNRTC::DestroyLocalTrack(screen_track_ptr_);\n screen_track_ptr_ = nullptr;\n }\n \n if (custom_video_track_ptr_) {\n QNRTC::DestroyLocalTrack(custom_video_track_ptr_);\n custom_video_track_ptr_ = nullptr;\n }\n \n if (microphone_audio_track_ptr_) {\n QNRTC::DestroyLocalTrack(microphone_audio_track_ptr_);\n microphone_audio_track_ptr_ = nullptr;\n }\n \n if (custom_audio_track_ptr_) {\n QNRTC::DestroyLocalTrack(custom_audio_track_ptr_);\n custom_audio_track_ptr_ = nullptr;\n }\n \n if (rtc_client_ptr_) {\n QNRTC::DestroyClient(rtc_client_ptr_);\n rtc_client_ptr_ = nullptr;\n }\n QNRTC::DeInint();\n \n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频SDK 概览"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Linux >SDK 概览\n\n# SDK 概览\n\n最近更新时间: 2022-07-13 23:53:33\n\n## 概述\n\nQNRTC-Linux 是七牛云推出的一款适用于 Linux 平台的实时音视频 C++ SDK,提供了灵活的接口,支持高度定制以及二次开发。\n\n## 场景介绍\n\nQNRTC-Linux 适用于一对一、一对多、多对多的实时语音聊天、唱歌、教学、医疗等场景,同时可与其它平台 Android、iOS、Web、Windows\n等平台互通。\n\n## 下载地址\n\n * [Linux Demo 以及 SDK 下载地址](https://github.com/pili-engineering/QNRTC-Linux)\n\n## 功能列表\n\n功能| 版本 \n---|--- \n支持多重混音功能| v5.1.0(+) \n支持 arm_linux_gnueabihf 架构| v5.0.2(+) \n支持外部视频 h264| v5.0.1(+) \n增加单路转推成功的回调| v5.0.0(+) \n支持摄像头切换图片连麦| v5.0.0(+) \n支持合流时单独设置 Track 填充模式| v5.0.0(+) \n支持摄像头采集数据镜像功能| v5.0.0(+) \n增加远端用户重连中/重连成功消息通知| v5.0.0(+) \n新增大小流功能| v5.0.0(+) \n新增单路转推功能| v5.0.0(+) \n新增收发自定义消息功能| v5.0.0(+) \n新增创建自定义合流任务功能| v5.0.0(+) \n新增回声消除的动态开关| v5.0.0(+) \n支持同时订阅多路视频 Track| v5.0.0(+) \n支持外部音频数据导入| v5.0.0(+) \n支持外部视频数据导入| v5.0.0(+) \n基本的音视频通话功能| v5.0.0(+) \n支持纯音频通话| v5.0.0(+) \n支持音频调节功能| v5.0.0(+) \n支持视频帧率配置| v5.0.0(+) \n支持视频码率的配置| v5.0.0(+) \n支持视频尺寸配置| v5.0.0(+) \n支持网络自动重连| v5.0.0(+) \n支持获取通话质量统计信息| v5.0.0(+ \n支持房间状态回调| v5.0.0(+ \n支持本地音视频采集数据的回调| v5.0.0(+ \n支持远端音视频渲染数据的回调| v5.0.0(+) \n \n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频开发准备"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Linux >开发准备\n\n# 开发准备\n\n最近更新时间: 2022-06-15 16:57:31\n\n## 开发语言以及系统要求\n\n * 开发语言:C/C++\n * 系统要求:Linux 平台\n\n## 开发环境\n\n * Ubuntu 16.04+\n * CMake\n * GCC5 及以上\n\n> 用户可根据自己的开发习惯或环境自由选择开发方式,以下章节只介绍基于 `CMake` 生成 `Makefile`的开发配置。\n\n## 导入 SDK\n\n * 将 `Release/linux/include` 复制到自己的头文件目录\n * 将 `Release/linux/lib` 目录添加到项目库搜索路径\n\n## 编译运行 Demo\n\n \n \n cd src/linux/RtcDemo\n chmod a+x build.sh\n # x86_64\n ./build.sh x86_64\n # arm_linux_gnueabihf\n ./build.sh arm_linux_gnueabihf\n \n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频实现视频通话"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Linux >实现视频通话\n\n# 实现视频通话\n\n最近更新时间: 2022-03-28 15:58:53\n\n## 初始化\n\n首先需要全局初始化 SDK,请确保仅调用一次\n\n \n \n using namespace std;\n using namespace qiniu;\n QNRTCSetting setting;\n QNRTC::Init(setting, nullptr);\n \n\n## 创建音视频通话核心类\n\n \n \n QNRTCClient* client = QNRTC::CreateClient(this);\n \n\n## 创建 Track\n\nTrack 代表了音视频通话过程中的一路音频或者一路视频,本文仅介绍一路音视频连麦的场景,创建方式如下:\n\n \n \n // 创建麦克风 Track\n QNMicrophoneAudioTrackConfig audio_track_config;\n audio_track_config.audio_quality = {sample_rate, channels, bits_per_sample, bitrate};\n QNMicrophoneAudioTrack audio_track = QNRTC::CreateMicrophoneAudioTrack(audio_track_config);\n \n // 创建相机 Track\n QNCameraVideoTrackConfig video_track_config;\n video_track_config.id = camera_device_id;\n video_track_config.capture_config = {width, height, fps};\n video_track_config.encoder_config = {width, height, fps, bitrate};\n QNCameraVideoTrack video_track = QNRTC::CreateCameraVideoTrack(video_track_config);\n \n\n## 枚举视频采集设备\n\n获取本地视频采集设备数量,以及其所支持的采集参数:\n\n \n \n // 获取本地视频采集设备数量\n int count = QNRTC::GetCameraCount();\n // 遍历本地视频采集设备\n for (int i = 0; i < count; ++i) {\n auto camera_info = QNRTC::GetCameraInfo(i);\n }\n \n \n\n## 加入房间\n\n上文提到过,SDK 所有的功能都是从 `RoomToken` 开始的,所以加入房间只需要将 `RoomToken` 作为参数传给 SDK\n就可以了。示例代码如下:\n\n \n \n client->Join(room_token, user_data);\n \n\n加入房间成功后会触发 `QNClientEventListener.OnConnectionStateChanged` 回调\n`QNConnectionState.CONNECTED` 状态。此时即可进行发布、订阅等操作。\n\n> 注:此处 `room_token` 建议开发者的应用程序从自己的 Server 端获取,关于 Server 如何生成 token\n> 可查阅[服务端开发文档](https://developer.qiniu.com/rtc/8813/roomToken)。\n\n## 发布音/视频\n\n成功加入房间后,即可在 `QNClientEventListener.OnConnectionStateChanged` 回调中调用以下代码进行本地\nTrack 的发布:\n\n \n \n void OnConnectionStateChanged(qiniu::QNConnectionState state, const qiniu::QNConnectionDisconnectedInfo& info)\n {\n if (state == CONNECTED) {\n LocalTrackList local_track_list;\n local_track_list.push_front(audio_track);\n local_track_list.push_front(video_track);\n client->Publish(local_track_list, this);\n }\n }\n \n\n发布成功后,本地会收到 `QNPublishResultCallback.OnPublished` 回调。远端用户会收到\n`QNClientEventListener.OnUserPublished` 回调。\n\n## 订阅远端音/视频\n\nSDK 收到远端发布 `QNClientEventListener.OnUserPublished` 的回调,在此回调内则可进行对 Track\n的渲染窗口设置的操作,再进行订阅,如果用户默认设置了自动订阅,这里只需设置渲染窗口,不需要主动去订阅:\n\n \n \n void OnUserPublished(const std::string &remote_user_id,\n const qiniu::RemoteTrackList &track_list)\n {\n if (client) {\n client->Subscribe(track_list);\n }\n }\n \n\n注:Linux 由于桌面平台多样性, 暂不支持视频渲染,如需要渲染,可以使用\n`QNRemoteVideoTrack.SetVideoFrameListener` 获取视频每一帧数据\n\n在成功订阅之后,用户可以根据业务场景的需求在适当的时间调用取消订阅的接口取消订阅相应的 Track:\n\n \n \n client.UnSubscribe(track_list);\n \n\n## 离开房间\n\n当音视频通话结束,调用以下代码离开房间:\n\n \n \n client->Leave();\n \n\n## 销毁\n\n用户需要调用以下代码对资源进行释放,一般此操作建议在程序生命周期的 `OnDestroy()` 中进行,示例代码如下:\n\n \n \n if (audio_track_) {\n QNRTC::DestroyLocalTrack(audio_track_);\n }\n if (video_track_) {\n QNRTC::DestroyLocalTrack(video_track_);\n }\n \n\n## 反初始化\n\n当用户不再使用 SDK,需要使用反初始化方法,释放所有资源\n\n \n \n QNRTC::DeInint();\n \n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频SDK 概览"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > WXApp >SDK 概览\n\n# SDK 概览\n\n最近更新时间: 2022-03-04 10:22:24\n\n这是一款适用于 微信小程序 的七牛实时音视频 SDK,提供了包括音视频通话、静音、发布、订阅等多种功能,基于此 SDK,您可以在 小程序\n上开发出一款基于实时音视频的应用。 其中包括但不限于以下场景\n\n * 在线教育\n * 主播观众连麦\n * 视频会议\n * 一对一社交\n * 狼人杀等依赖实时音视频通话的游戏\n * 在线客服\n * 在线抓娃娃\n\n您可以扫以下二维码 ,体验我们最新的 Demo 效果。\n\n\n\n# 微信兼容性\n\nAndroid| iOS \n---|--- \n7.0.0| 7.0.0 \n \n# SDK 功能列表\n\n以下是 SDK 截止到最新版本所提供的功能列表\n\n功能| 版本 \n---|--- \n基本的音视频通话功能| v4.0.1 \n合流和自定义消息| v4.0.1 \n单路转推| v4.0.1 \n订阅主讲的共享画面| v4.0.1 \n控制合流发布显示模式相关问题| v4.0.1 \n支持静音功能| v4.0.1 \n \n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频开发准备"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > WXApp >开发准备\n\n# 开发准备\n\n最近更新时间: 2022-03-21 19:10:35\n\n# 开始之前\n\n 1. 请先确认您已经对这个产品有了大概的了解,并且已经完成了[七牛实时音视频云接入流程](https://developer.qiniu.com/rtc/8802/pd-overview)。\n 2. 请先了解小程序开发,阅读 [微信小程序开发者文档](https://developers.weixin.qq.com/miniprogram/dev/index.html) 。\n 3. 请在微信小程序后台 -> 开发 -> 开发设置 -> 服务器域名配置中,将 `wss://rtmpgate.cloudvdn.com` 加到 socket 合法域名中,将 `https://pili-rtc-qos.qiniuapi.com` 添加到 request 合法域名中。\n 4. 在小程序的开发后台打开实时播放/录制音视频流的开关(小程序后台 -> 开发 -> 接口设置)。\n\n# 引入 SDK\n\n### NPM 安装\n\n \n \n npm install --save qnwxapp-rtc\n \n\n### SDK 引入\n\n> 引入之后必须点击 微信开发者工具 > 工具 > 构建 npm 方可使用。关于在小程序中使用 npm 包,详情见微信官方文档 [npm\n> 支持](https://developers.weixin.qq.com/miniprogram/dev/devtools/npm.html) 。\n \n \n import { QNRTC } from 'qnwxapp-rtc'\n \n console.log(QNRTC.VERSION)\n \n const client = QNRTC.createClient()\n \n \n\n### 引入组件\n\n接下来,在页面的 `wxml` 中引入 [live-\npusher](https://developers.weixin.qq.com/miniprogram/dev/component/live-\npusher.html) 和 [live-\nplayer](https://developers.weixin.qq.com/miniprogram/dev/component/live-\nplayer.html)。\n\n \n \n <view>\n <live-pusher mode=\"RTC\" url=\"...\"></live-pusher>\n <live-player mode=\"RTC\" src=\"...\"></live-player>\n </view>\n \n\n> **注意** : 如果您需要在微信开发者工具上跑通我们的 demo ,请先在 demo 目录下执行 `npm install` ,然后点击\n> 微信开发者工具 > 工具 > 构建 npm 即可。\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频实现视频通话"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > WXApp >实现视频通话\n\n# 实现视频通话\n\n最近更新时间: 2022-08-08 16:49:13\n\n# 初始化房间并加入房间\n\n到这里您应该已经完成了开发准备,您已经可以拿到 RoomToken 。SDK 通过传入 RoomToken 来完成加入房间。RoomToken\n是一个包含了一次连麦所需要的主要信息的 token,这些信息包括 七牛的账户标识、连麦的应用 ID(appId)、连麦的房间号\n(roomName)、连麦的用户名(userId)、有效期等等。\n\n> 如果您还不知道如何生成 RoomToken,请先阅读\n> [七牛实时音视频云接入指南](https://developer.qiniu.com/rtc/8802/pd-overview) 。\n \n \n import { QNRTC } from 'pili-rtc-wxapp'\n // 初始化客户端\n const client = QNRTC.createClient()\n // 加入房间\n await client.join(roomToken, userData);\n \n\n# 发布流\n\n加入房间之后我们需要调用\n[publish](https://developer.qiniu.com/rtc/10950/WXAppQNRTCClient#publish)\n,该方法的回调会返回推流 **rtmp** 地址,将该地址传入 **live-pusher** 组件,即可完成流的发布。\n\n \n \n <!-- index.wxml -->\n <live-pusher\n autopush\n mode=\"RTC\"\n url=\"{{publishPath}}\"\n >\n </live-pusher>\n \n \n \n import { QNPublishStatus } from \"pili-rtc-wxapp\"\n \n client.publish((status, data) => {\n /** \n * status 共有 READY 、COMPLETED、ERROR 三种状态\n * 其中 READY 表示推流就绪,返回推流的 rtmp 地址\n * COMPLETED 表示推流成功,返回推流生成的音频轨和视频轨\n * ERROR 则表示推流失败\n */\n if(status === QNPublishStatus.READY) {\n this.setData({\n publishPath: data.url\n })\n }\n })\n \n\n# 订阅流\n\n从上文发布的过程中我们可以知道,推流成功后一般会生成一个视频 `Track` 和一个音频 `Track` ,但是除了 **小程序 SDK** 外,在使用\n**七牛Web SDK** 或其余 **SDK** 时, 一个用户可以发布多个音视频 `Track` ,在实际需求中我们不一定会把他所有发布的\n`Track` 都订阅(可能只订阅音频之类的),所以订阅的目标是以 `Track` 为单位的。\n\n### 获取 `Track`\n\n那么,我怎么知道房间中有哪些 `Track` ,这些 `Track` 又分别对应哪些用户呢?这就是我们接下来讲述的重点。\n\n我们可以通过 SDK 的 `user-published` 事件获取当前房间的 `Track` 列表:\n\n> 需要在join房间之前监听对应事件,`join` 加入房间成功后,`user-published` 会返回当前所有房间内已发布 `Track`\n> 列表以及用户 `userID` 。\n\n进入房间后,当一个远端用户发布了自己的 `Track` ,此时在我们这边也会触发 `user-published` 事件,事件会带上远端用户的\n`userID` 以及所发布的 `Track` 列表。\n\n### 订阅\n\n当我们获取到 `Track` 后,可以通过调用\n[subscribe](https://developer.qiniu.com/rtc/10950/WXAppQNRTCClient#subscribe)\n传入需要订阅的 `Track` ,将该方法返回推流的 **rtmp** 地址传入 **live-player** 组件,即可完成流的拉取。\n\n \n \n <!-- index.wxml -->\n <live-player\n autoplay\n wx:for=\"{{subscribeList}}\"\n src=\"{{item}}\"\n mode=\"RTC\"\n >\n </live-player>\n \n \n \n // index.js\n // 初始化客户端\n const client = QNRTC.createClient();\n client.on(\"user-published\", async (user, tracks) => {\n console.log(\"event: user-published - 用户发布\", user, tracks);\n let config = {};\n let videoTrack = tracks.find((item) => item.isVideo());\n let audioTrack = tracks.find((item) => item.isAudio());\n if (videoTrack) {\n config.videoTrack = videoTrack;\n }\n if (audioTrack) {\n config.audioTrack = audioTrack;\n }\n const url = await client.subscribe(config);\n this.setData({\n subscribeList: [...this.data.subscribeList,url],\n });\n });\n // 加入房间\n await client.join(roomToken, userData);\n \n\n> 需要注意的是:subscribe 所传入的 `Track` 必须是同一个用户所推流的。\n\n# 离开房间\n\n离开房间,断开信令,一般在 生命周期 onUnload 里调用。\n\n \n \n Page({\n onUnload() {\n client.leave()\n }\n })\n \n\n# 断网重连\n\n默认情况下,当发生网络异常等情况,SDK 会进入自动重连状态,此时房间连接状态会变为 RECONNECTING,表示重连中。之后就会两种可能:\n\n第一种,此后如果网络状态恢复正常,则 SDK 会完成自动重连,房间连接状态会变为 RECONNECTED,表示重连成功。。\n\n第二种,如果 SDK 自动重连后,仍然无法正常连接网络,则 SDK 会自动退出房间,此时房间连接状态变为\nDISCONNECTED,表示断开连接。在断开连接状态时,[回调函数](https://developer.qiniu.com/rtc/10950/WXAppQNRTCClient#CONNECTION_STATE_CHANGED)中会带有第二个参数\n[QNConnectionDisconnectedInfo](https://developer.qiniu.com/rtc/10943/WXAppQNConnectionDisconnectedInfo),用来表示断开的原因。此时应当根据断开原因不同,做不同的逻辑处理。具体见如下代码。\n\n \n \n client.on('connection-state-changed', (connectionState, info) => {\n console.log('connection-state-changed', connectionState);\n \n // 当进入连接断开状态\n if (connectionState === QNConnectionState.DISCONNECTED) {\n \n // 监控断开原因\n switch(info.reason) {\n \n // 当异常断开时\n case QNConnectionDisconnectedReason.ERROR:\n break;\n \n // 当被踢出房间时\n case QNConnectionDisconnectedReason.KICKED_OUT:\n break;\n \n // 当调用接口,主动离开房间时\n case QNConnectionDisconnectedReason.LEAVE:\n break;\n \n }\n })\n \n\n此时,最需要关注的是异常断开的情况。一般处理模式有两种:\n\n * 通知用户:展示 UI,通知用户网络异常,用户可选择调整网络后重试\n * 自动重连:可以在收到异常断开的通知后,主动调用重新加入房间的方法,主动再次重试\n\n# 结语\n\n到了这里我们已经了解 SDK 的基本使用方式。 更多请参考我们的 github 开源 [Demo](https://github.com/pili-\nengineering/QNRTC-WxApp)\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频SDK 概览"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Uniapp >SDK 概览\n\n# SDK 概览\n\n最近更新时间: 2023-12-18 15:10:40\n\n> 具体 demo 可见 [github](https://github.com/pili-engineering/QNRTC-\n> Uniapp/tree/main/demo) 仓库,该 demo 已集成 **前端 SDK** 与 **原生 SDK** ,直接制作自定义基座,填写\n> **iOS** 或 **Android** 证书,即可运行。\n\n**QNRTC-Uniapp** 是基于 **[UNIAPP](https://uniapp.dcloud.io/)** 、 **[QNRTC-\nAndroid](https://developer.qiniu.com/rtc/8764/an-overview-of-the-android-\nsdk)** 以及 **[QNRTC-iOS](https://developer.qiniu.com/rtc/8830/an-overview-of-\nthe-ios-sdk)** 三者所实现的。前端可通过 **QNRTC-Uniapp** 所提供的 **JS 插件** 与 **Native 插件**\n调用原生 `Android` 以及 `iOS` 的 RTC 接口来实现实时音视频通话。\n\n其中包括但不限于以下场景\n\n * 在线教育\n * 主播观众连麦\n * 视频会议\n * 一对一社交\n * 狼人杀等依赖实时音视频通话的游戏\n * 在线客服\n * 在线抓娃娃\n\n# SDK 功能列表\n\n以下是 SDK 截止到最新版本所提供的功能列表\n\n功能| 版本 \n---|--- \n支持视频 SEI| v1.0.0 \n支持摄像头 Track 发送图片| v1.0.0 \n支持编码数据加密传输| v1.0.0 \n支持远端音频播放音量调节| v1.0.0 \n支持大小流传输| v1.0.0 \n支持单路转推| v1.0.0 \n支持配置 RTC 与其他音频同时播放| v1.0.0 \n支持音量大小回调| v1.0.0 \n支持自定义消息| v1.0.0 \n支持使用 TCP 传输媒体流| v1.0.0 \n支持使用蓝牙耳机通话| v1.0.0 \n支持扬声器/听筒切换| v1.0.0 \n支持音视频分别发布| v1.0.0 \n支持发布多路视频| v1.0.0 \n支持回调本地音频数据| v1.0.0 \n支持回调远端音频数据| v1.0.0 \n支持回调远端视频数据| v1.0.0 \n支持编码镜像| v1.0.0 \n支持合流参数配置| v1.0.0 \n支持后台连麦| v1.0.0 \n支持纯音频连麦| v1.0.0 \n支持硬件编码| v1.0.0 \n支持码率上下限配置| v1.0.0 \n支持多分辨率编码| v1.0.0 \n支持回调本地视频数据| v1.0.0 \n支持实时美颜滤镜| v1.0.0 \n支持水印功能| v1.0.0 \n支持踢人功能| v1.0.0 \n支持静音功能| v1.0.0 \n支持自动/手动对焦| v1.0.0 \n支持实时状态回调| v1.0.0 \n支持回调连麦房间统计信息| v1.0.0 \n支持丰富的连麦消息回调| v1.0.0 \n支持混音功能| v1.0.1 \n支持多重混音功能| v5.2.7 \n支持跨房连麦| v5.2.7 \n \n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频开发准备"

},

{

"from": "gpt",

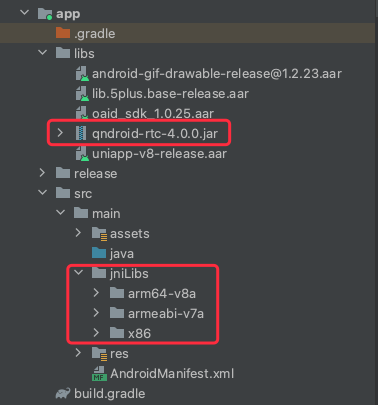

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Uniapp >开发准备\n\n# 开发准备\n\n最近更新时间: 2024-04-28 10:53:23\n\n# 开始之前\n\n 1. 请先确认您已经对这个产品有了大概的了解,并且已经完成了[七牛实时音视频云接入流程](https://developer.qiniu.com/rtc/8802/pd-overview)。\n 2. 请先了解uniapp原生开发,阅读 [uniapp开发者文档](https://uniapp.dcloud.io/) 。\n\n# 引入 SDK\n\n### 插件市场安装\n\n> 需要在插件市场加载 [JS 插件](https://ext.dcloud.net.cn/plugin?id=6859) 以及 [Native\n> 插件](https://ext.dcloud.net.cn/plugin?id=6857)。JS\n> 插件主要负责处理加工原生返回的数据,便于使用者调用,Native 插件负责直接调用原生接口返回 JS 插件。\n\n### SDK 引用\n\n \n \n import { QNRTC } from \"@/js_sdk/QNRTC-UniPlugin-JS/QNRTC-UniPlugin-JS/RTCIndex.native.js\"\n QNRTC.init()\n const client = QNRTC.createClient()\n \n \n\n### 引入组件\n\n \n \n <QNRTC-UniPlugin-SurfaceView class=\"track-video\" v-for=\"(item,index) in localTracks\" :key=\"item.identifyID\" v-if=\"item.kind === 'video'\" :local=\"0\" :identifyID=\"item.identifyID\" fillMode=\"QNVideoFillModePreserveAspectRatioAndFill\" :trackID=\"item.trackID\"></QNRTC-UniPlugin-SurfaceView>\n <QNRTC-UniPlugin-SurfaceView class=\"track-video\" v-for=\"(item,index) in remoteTracks\" :key=\"item.identifyID\" v-if=\"item.kind === 'video'\" :local=\"1\" :identifyID=\"item.identifyID\" :userID=\"item.userID\" fillMode=\"QNVideoFillModePreserveAspectRatioAndFill\" :trackID=\"item.trackID\"></QNRTC-UniPlugin-SurfaceView>\n \n\n * local: 0 本地 track 视图,1 远端 track 视图\n * identifyID: uniapp 中每个 track 的唯一标识符\n * trackID: 服务器对于每个 track 的唯一标识符(track 未发布时该值为\"\")\n * userID 发布该 track 的 用户 ID(local = 1 时需要该属性)\n * fillMode 对应视图层的渲染模式(暂时只支持iOS)\n\n> **注意** : 除了**云打包** ,sdk还支持 **离线打包** ,用户可以在 **Xcode** 和 **Android Studio**\n> 进行打包编译,这里建议使用 **HBuilderX** 进行更为方便的云打包。\n\n### 离线打包\n\n \n \n git clone [email protected]:pili-engineering/QNRTC-Uniapp.git\n cd QNRTC-Uniapp\n \n\n#### 前端编译\n\n 1. `npm run build`\n 2. 将编译后的文件直接引入前端项目中使用即可\n\n#### iOS 编译\n\n> **iOS** 编译同时可以参考 **uniapp** 官方文档的\n> [编译原生插件](https://nativesupport.dcloud.net.cn/NativePlugin/course/ios) 与\n> [离线打包](https://nativesupport.dcloud.net.cn/AppDocs/README)。\n\n 1. 将 iOS 文件工程放到 uni-app 离线 SDK 对应的目录中 (**HBuilder-uniPluginDemo**)\n 2. 引入 uni-app 离线 SDK \n * 在 Xcode 中右键 **HBuilder-uniPlugin** 工程,并点击 **Add Files to \"HBuilder-uniPlugin\"** , 选中 **QNRtcUniPlugin.xcodeproj** 并添加\n * 在 Xcode 中点击 **HBuilder-uniPlugin** 工程,并点击 **HBuilder** Target,选中 **Build Phases**\n * 在 **Dependencies** 中添加 **QNRtcUniPlugin**\n * 在 **Link Binary With Libraries** 中添加 **QNRtcUniPlugin.framework**\n * 在 **Embed Frameworks** 中添加 **QNRTCKit.framework** **HappyDNS.framework** (需要通过 **Add Other...** 选择 **ios/** 目录中的 **.framework** 文件添加)\n 3. 配置插件信息\n\n搜索 **HBuilder-uniPlugin-Info.plist** ,右键 **open as source code** ,然后找到 **< key\n>dcloud_uniplugins< /key >** ,添加如下代码:\n\n \n \n <dict>\n <key>hooksClass</key>\n <string></string>\n <key>plugins</key>\n <array>\n <dict>\n <key>class</key>\n <string>QNRtcEngine</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-QNRtcEngine</string>\n <key>type</key>\n <string>module</string>\n </dict>\n <dict>\n <key>class</key>\n <string>QNRtcClient</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-QNRtcClient</string>\n <key>type</key>\n <string>module</string>\n </dict>\n <dict>\n <key>class</key>\n <string>QNRtcAudioMusicMixer</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-QNRtcAudioMusicMixer</string>\n <key>type</key>\n <string>module</string>\n </dict>\n <dict>\n <key>class</key>\n <string>QNRtcAudioEffectMixer</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-QNRtcAudioEffectMixer</string>\n <key>type</key>\n <string>module</string>\n </dict>\n <dict>\n <key>class</key>\n <string>QNRtcAudioEffect</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-QNRtcAudioEffect</string>\n <key>type</key>\n <string>module</string>\n </dict>\n <dict>\n <key>class</key>\n <string>QNRtcTrack</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-QNRtcTrack</string>\n <key>type</key>\n <string>module</string>\n </dict>\n <dict>\n <key>class</key>\n <string>QNRtcAudio</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-QNRtcAudio</string>\n <key>type</key>\n <string>module</string>\n </dict>\n <dict>\n <key>class</key>\n <string>QNRtcSurfaceView</string>\n <key>name</key>\n <string>QNRTC-UniPlugin-SurfaceView</string>\n <key>type</key>\n <string>component</string>\n </dict>\n </array>\n </dict>\n \n\n#### Android 编译\n\n> **Android** 编译同时可以参考 **uniapp** 官方文档的\n> [编译原生插件]<https://nativesupport.dcloud.net.cn/NativePlugin/course/android>) 与\n> [离线打包](https://nativesupport.dcloud.net.cn/AppDocs/README)。\n\n 1. 将 Android 文件夹中 **uniplugin_qndroid_rtc** 工程以 module 的形式导入到 uni-app 离线 SDK 对应的目录中 (UniPlugin-Hello-AS),导入方式可参考[官方文档](https://developer.android.com/studio/projects/add-app-module?hl=zh-cn#ImportAModule)。\n 2. 将 Android 文件夹中 **QNRtcUniPlugin/android/libs** 目录下的 jar 文件放到 uni-app 离线 SDK 对应的 **app/libs/** 目录中,不同架构的 so 文件放到 **app/src/main/jniLibs/** 目录中,如无 jniLibs 目录,需手动创建。集成后的目录结构如下:\n\n\n\n 3. 在 settings.gradle 中添加\n\n \n \n include ':uniplugin_qndroid_rtc'\n \n\n 4. 在 app/build.gradle 中添加\n\n \n \n implementation 'com.qiniu:happy-dns:0.2.18'\n implementation \"com.google.code.gson:gson:2.8.8\"\n implementation project(':uniplugin_qndroid_rtc')\n \n\n 5. 配置插件信息\n\n \n \n {\n \"nativePlugins\": [\n {\n \"plugins\": [\n {\n \"type\": \"module\",\n \"name\": \"QNRTC-UniPlugin-QNRtcEngine\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.module.QNRTCModule\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"module\",\n \"name\": \"QNRTC-UniPlugin-QNRtcClient\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.module.QNRTCClientModule\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"module\",\n \"name\": \"QNRTC-UniPlugin-QNRtcTrack\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.module.QNRTCTrackModule\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"module\",\n \"name\": \"QNRTC-UniPlugin-QNRtcAudioMixer\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.module.QNRTCAudioMixerModule\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"module\",\n \"name\": \"QNRTC-UniPlugin-QNRtcAudioMusicMixer\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.module.QNRTCAudioMusicMixerModule\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"module\",\n \"name\": \"QNRTC-UniPlugin-QNRtcAudioEffectMixer\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.module.QNRTCAudioEffectMixerModule\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"module\",\n \"name\": \"QNRTC-UniPlugin-QNRtcAudioEffect\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.module.QNRTCAudioEffectModule\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"component\",\n \"name\": \"QNRTC-UniPlugin-SurfaceView\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.component.QNRTCSurfaceView\"\n }\n ]\n },\n {\n \"plugins\": [\n {\n \"type\": \"component\",\n \"name\": \"QNRTC-UniPlugin-TextureView\",\n \"class\": \"uni.qiniu.droid.uniplugin_rtc.uni.component.QNRTCTextureView\"\n }\n ]\n }\n ]\n }\n \n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频实现视频通话"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 快速入门 > Uniapp >实现视频通话\n\n# 实现视频通话\n\n最近更新时间: 2023-12-18 15:11:10\n\n# 初始化房间并加入房间\n\n到这里您应该已经完成了开发准备,您已经可以拿到 RoomToken 。SDK 通过传入 RoomToken 来完成加入房间。RoomToken\n是一个包含了一次连麦所需要的主要信息的 token,这些信息包括 七牛的账户标识、连麦的应用 ID(appId)、连麦的房间号\n(roomName)、连麦的用户名(userId)、有效期等等。\n\n> 如果您还不知道如何生成 RoomToken,请先阅读\n> [七牛实时音视频云接入指南](https://developer.qiniu.com/rtc/8802/pd-overview) 。\n \n \n import { QNRTC } from \"@/js_sdk/QNRTC-UniPlugin-JS/QNRTC-UniPlugin-JS/RTCIndex.native.js\"\n // 必须在使用其它接口前调用\n QNRTC.init()\n // 初始化客户端\n const client = QNRTC.createClient()\n // 加入房间\n await client.join(roomToken, userData);\n \n\n# 添加原生 component 组件\n\n添加音视频通话需要的原生组件\n\n \n \n <QNRTC-UniPlugin-SurfaceView class=\"track-video\" v-for=\"(item,index) in localTracks\" :key=\"item.identifyID\" v-if=\"item.kind === 'video'\" :local=\"0\" :identifyID=\"item.identifyID\" fillMode=\"QNVideoFillModePreserveAspectRatioAndFill\" :trackID=\"item.trackID\"></QNRTC-UniPlugin-SurfaceView>\n <QNRTC-UniPlugin-SurfaceView class=\"track-video\" v-for=\"(item,index) in remoteTracks\" :key=\"item.identifyID\" v-if=\"item.kind === 'video'\" :local=\"1\" :identifyID=\"item.identifyID\" :userID=\"item.userID\" fillMode=\"QNVideoFillModePreserveAspectRatioAndFill\" :trackID=\"item.trackID\"></QNRTC-UniPlugin-SurfaceView>\n \n\n * local: 0 本地 track 视图,1 远端 track 视图\n * identifyID: uniapp 中每个 track 的唯一标识符\n * trackID: 服务器对于每个 track 的唯一标识符(track 未发布时该值为\"\")\n * userID 发布该 track 的 用户 ID(local = 1 时需要该属性)\n * fillMode 对应视图层的渲染模式(暂时只支持iOS)\n\n# 采集音视频轨\n\n这里我们将要采集 2 个音视频轨,分别是 **摄像头视频轨** 和 **麦克风音频轨** 。\n\n \n \n const cameraVideoTrack = QNRTC.createCameraVideoTrack()\n const microphoneAudioTrack = QNRTC.createMicrophoneAudioTrack()\n \n\n# 发布本地音视频轨\n\n成功加入房间后,可在\n[**onConnectionStateChanged**](https://developer.qiniu.com/rtc/11404/UniappQNRTCClinetEvent#onConnectionStateChanged)\n事件中 **state** 为 **QNConnectionState.CONNECTED** 后发布本地 Track 。\n\n \n \n this.client.on(\"onConnectionStateChanged\", ({\n state\n }) => {\n if (state === QNConnectionState.CONNECTED) {\n this.client.publish(this.localTracks, ({\n onPublished,\n data,\n info\n }) => {\n if (onPublished) {\n // ...\n } else {\n // ...\n }\n })\n }\n })\n \n\n发布成功后,本地通过回调获得发布成功的结果。而远端用户则会通过\n[**onUserPublished**](https://developer.qiniu.com/rtc/11404/UniappQNRTCClinetEvent#onUserPublished)\n收到发布成功的回调。\n\n# 订阅远端音视频 Track\n\nSDK 默认会进行自动订阅,订阅成功后根据媒体类型收到\n[**onAudioSubscribed**](https://developer.qiniu.com/rtc/11404/UniappQNRTCClinetEvent#onAudioSubscribed)\n或者\n[**onVideoSubscribed**](https://developer.qiniu.com/rtc/11404/UniappQNRTCClinetEvent#onVideoSubscribed)\n的回调,然后通过原生组件传入对应参数,实现远端窗口显示。\n\n \n \n this.client.on(\"onAudioSubscribed\", (params) => {\n for (let i of params.trackList) {\n this.remoteTracks.push(i)\n }\n })\n this.client.on(\"onVideoSubscribed\", (params) => {\n for (let i of params.trackList) {\n this.remoteTracks.push(i)\n }\n })\n \n\n# 订阅流\n\n从上文发布的过程中我们可以知道,推流成功后一般会生成一个 **Track** ,一个用户可以发布多个音视频 **Track**\n,在实际需求中我们不一定会把他所有发布的 **Track** 都订阅(可能只订阅音频之类的),所以订阅的目标是以 **Track** 为单位的。\n\n我们可以通过 SDK 的\n[**onUserPublished**](https://developer.qiniu.com/rtc/11404/UniappQNRTCClinetEvent#onUserPublished)\n事件获取当前房间发布的 **Track** 。\n\n \n \n this.client.on(\"onUserPublished\", (params) => {\n console.log(params.trackList)\n })\n \n\n> 需要在join房间之前监听对应事件,**join**\n> 加入房间成功后,[**onUserPublished**](https://developer.qiniu.com/rtc/11404/UniappQNRTCClinetEvent#onUserPublished)\n> 会返回当前所有房间内已发布 **Track** 列表以及用户 **userID** 。\n\n进入房间后,当一个远端用户发布了自己的 **Track** ,此时在我们这边也会触发\n[**onUserPublished**](https://developer.qiniu.com/rtc/11404/UniappQNRTCClinetEvent#onUserPublished)\n事件,事件会带上远端用户的 **userID** 以及所发布的 **Track** 列表。\n\n# 离开房间\n\n在进入音视频通话房间之后,用户可以根据业务场景的需求在适当的时间调用离开房间的接口退出连麦。例如客户端踢人:\n\n \n \n client.on(\"onMessageReceived\", (params) => {\n if(params.content === \"kickOut\") {\n client.leave()\n }\n })\n \n\n#### 销毁\n\n在整个页面销毁时,用户需要调用以下代码对资源进行释放,一般此操作建议在页面生命周期 **onUnload** 和 **onBackPress**\n中进行,示例代码如下:\n\n \n \n onUnload() {\n this.client.leave()\n QNRTC.deinit()\n }\n onBackPress() {\n this.client.leave()\n QNRTC.deinit()\n }\n \n\n# 结语\n\n到了这里我们已经了解 SDK 的基本使用方式。 \n更多请参考我们的 github 开源 [Demo __](https://github.com/pili-engineering/QNRTC-Uniapp)\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频初始化"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 使用指南 > Android >初始化\n\n# 初始化\n\n最近更新时间: 2023-08-17 15:50:46\n\n本文主要介绍实时音视频的初始化方式及其配置项。\n\n> 在使用 SDK 前,请务必调用\n> [QNRTC.init](https://developer.qiniu.com/rtc/api/8732/QNRTC#init%5B1/2%5D)\n> 方法进行 RTC 环境的初始化工作\n\n# 默认配置初始化\n\nQNRTC SDK 提供 [QNRTC.init(Context,\nQNRTCEventListener)](https://developer.qiniu.com/rtc/api/8732/QNRTC#init%5B1/2%5D)\n方法以默认配置进行 RTC 环境的初始化工作,示例代码如下:\n\n \n \n @Override\n protected void onCreate(Bundle savedInstanceState) {\n super.onCreate(savedInstanceState);\n // 以默认配置进行 RTC 环境的初始化,使用 SDK 前请务必先执行初始化操作。\n QNRTC.init(this, new QNRTCEventListener());\n }\n \n\n若 [QNRTCSetting](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting)\n的默认配置无法满足您的场景需要,您还可通过调用 [QNRTC.init(Context, QNRTCSetting,\nQNRTCEventListener)](https://developer.qiniu.com/rtc/api/8732/QNRTC#init%5B2/2%5D)\n方法进行自定义 [QNRTCSetting](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting)\n配置的初始化,[QNRTCSetting](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting)\n支持的配置及说明具体如下:\n\n# 设置视频的编码方式\n\n通过调用\n[QNRTCSetting.setHWCodecEnabled](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting#setHWCodecEnabled)\n接口配置编码方式,默认开启硬编\n\n \n \n public QNRTCSetting setHWCodecEnabled(boolean enabled)\n \n\n# 设置是否固定分辨率\n\n通过调用\n[QNRTCSetting.setMaintainResolution](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting#setMaintainResolution)\n设置是否固定分辨率,默认开启分辨率自适应\n\n \n \n public QNRTCSetting setMaintainResolution(boolean maintainResolution)\n \n\n> * **该设置选项从`v5.2.3` 开始废弃,将在后续版本移除**,新的配置入口可在[创建视频\n> Track](https://developer.qiniu.com/rtc/development_guidelines/8767/audio-\n> and-video-collection-android) 时通过\n> [QNVideoEncoderConfig](https://developer.qiniu.com/rtc/api/8701/QNVideoEncoderConfig#QNVideoEncoderConfig%5B2/4%5D)\n> 来指定。保持分辨率可将\n> [QNDegradationPreference](https://developer.qiniu.com/rtc/api/12393/QNDegradationPreference)\n> 设置为\n> [QNDegradationPreference.MAINTAIN_RESOLUTION](https://developer.qiniu.com/rtc/api/12393/QNDegradationPreference#MAINTAIN_RESOLUTION)\n> * 对于已废弃接口,maintainResolution 为 true 对应\n> [QNDegradationPreference.MAINTAIN_RESOLUTION](https://developer.qiniu.com/rtc/api/12393/QNDegradationPreference#MAINTAIN_RESOLUTION),为\n> false 对应\n> [QNDegradationPreference.DEFAULT](https://developer.qiniu.com/rtc/api/12393/QNDegradationPreference#DEFAULT),可根据需要进行迁移\n>\n\n> 1. 该选项可以控制编码分辨率不会由于带宽控制策略而变化\n> 2. **单路转推 CDN 的场景下,请务必开启固定分辨率的选项,否则可能会出现不可预知的问题**\n>\n\n# 日志相关配置\n\n从 v5.2.3 开始,SDK 默认会进行日志的本地存储,同时支持日志的上报。\n\n## 基本配置\n\n可通过调用\n[QNRTC.setLogConfig](https://developer.qiniu.com/rtc/api/8732/QNRTC#setLogConfig)\n进行`日志等级`、`日志存储路径`以及`日志存储文件大小`的相关配置,示例代码如下:\n\n \n \n @Override\n protected void onCreate(Bundle savedInstanceState) {\n super.onCreate(savedInstanceState);\n QNRTC.init(this, new QNRTCEventListener()); // 初始化 RTC 环境\n QNLogConfig logConfig = new QNLogCofnig(this, QNLogLevel.INFO); // 创建 QNLogConfig\n QNRTC.setLogConfig(logConfig); // 设置 QNLogConfig\n }\n \n\n其中,`QNLogConfig`\n为主要的日志配置类,使用注意事项可参考[接口文档](https://developer.qiniu.com/rtc/api/12415/QNLogConfig)。\n\n>\n> [QNRTCSetting.setLogLevel](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting#setLogLevel)\n> 和\n> [QNRTC.setLogFileEnabled](https://developer.qiniu.com/rtc/api/8732/QNRTC#setLogFileEnabled)\n> 接口在 `v5.2.3` 之后已被废弃,请使用上述最新接口替代。\n\n## 日志上报\n\n可通过调用\n[QNRTC.uploadLog[1/2]](https://developer.qiniu.com/rtc/api/8732/QNRTC#uploadLog%5B1/2%5D)\n和\n[QNRTC.uploadLog[2/2]](https://developer.qiniu.com/rtc/api/8732/QNRTC#uploadLog%5B2/2%5D)\n接口进行日志文件的上报:\n\n \n \n public static void uploadLog(QNUploadLogResultCallback callback); // 上传日志到七牛服务器\n public static void uploadLog(String token, QNUploadLogResultCallback callback); // 上传日志到指定七牛云存储空间\n \n\n> 1. 调用上传接口前需要确保已经通过\n> [QNRTC.init](https://developer.qiniu.com/rtc/api/8732/QNRTC#init%5B1/2%5D)\n> 完成了 SDK 的初始化\n> 2. 若业务需要上传日志到自定义的七牛云存储空间,则需要您的业务服务器自行签算上传\n> token,签算规则可参考[上传策略](https://developer.qiniu.com/kodo/1208/upload-token%22)文档\n> 3. 日志上传结果及其相关错误码说明可参考\n> [QNUploadLogResultCallback](https://developer.qiniu.com/rtc/api/12414/QNUploadLogResultCallback)\n> 接口文档\n>\n\n# 设置是否将扬声器作为默认音频输出设备\n\n通过调用\n[QNRTCSetting.setDefaultAudioRouteToSpeakerphone](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting#setDefaultAudioRouteToSpeakerphone)\n设置是否将扬声器作为默认音频输出设备,默认音频路由为扬声器。\n\n \n \n public QNRTCSetting setDefaultAudioRouteToSpeakerphone(boolean defaultAudioRouteToSpeakerphone)\n \n\n# 设置媒体传输方式\n\n通过调用\n[QNRTCSetting.setTransportPolicy](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting#setTransportPolicy)\n设置媒体传输方式。默认使用 UDP 传输。\n\n \n \n public QNRTCSetting setTransportPolicy(TransportPolicy transportPolicy)\n \n\n其中,媒体传输方式有如下几种,可根据实际情况自行选择:\n\n \n \n public enum TransportPolicy {\n /**\n * 强制使用 UDP 做媒体传输(默认值)\n */\n FORCE_UDP,\n /**\n * 强制使用 TCP 做媒体传输\n */\n FORCE_TCP,\n /**\n * 优先使用 UDP 做媒体传输,允许自动切换 TCP\n */\n PREFER_UDP\n }\n \n\n# 设置音频场景\n\n通过调用\n[QNRTC.setAudioScene](https://developer.qiniu.com/rtc/api/8732/QNRTC#setAudioScene)\n设置音频场景,详细可阅读\n[音频场景实践](https://developer.qiniu.com/rtc/12267/audio_scene_android)。\n\n# 设置编码质量优先模式\n\n通过调用\n[QNRTCSetting.setEncoderQualityMode](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting#setEncoderQualityMode)\n设置开启编码质量优先模式,默认为关闭状态,使用码率优先模式。\n\n \n \n public QNRTCSetting setEncoderQualityMode(boolean encoderQualityMode)\n \n\n> 质量优先模式会优先保证视频的编码质量,实际码率可能会和目标码率存在差异。关闭该模式后会尽量控制编码码率为目标码率。\n\n# 设置重连时长\n\nSDK 默认会有 30s 的重连时间,通过调用\n[QNRTCSetting.setReconnectionTimeout](https://developer.qiniu.com/rtc/api/8686/QNRTCSetting#setReconnectionTimeout)\n可以修改重连时长的配置。\n\n \n \n public QNRTCSetting setReconnectionTimeout(int reconnectionTimeout)\n \n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频音视频采集"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 使用指南 > Android >音视频采集\n\n# 音视频采集\n\n最近更新时间: 2023-04-25 10:33:44\n\n音视频 [Track](https://developer.qiniu.com/rtc/quick_start/9909/the-rtc-basic-\nconcept#track) 为音视频交互的基本单位,本文主要介绍音视频 Track 的创建及采集等功能的使用。\n\n> * 一路 Track 代表一路音频或者视频的数据\n> * SDK 支持创建并发布多路音视频 Track。(v5.2.3 之前不支持多音频 Track,重复创建将会失败)\n>\n\n# 摄像头视频 Track\n\n[QNCameraVideoTrack](https://developer.qiniu.com/rtc/api/8640/QNCameraVideoTrack)\n为摄像头采集的本地 track,其创建方式如下:\n\n \n \n QNCameraVideoTrackConfig cameraVideoTrackConfig = new QNCameraVideoTrackConfig(TAG_CAMERA)\n .setCameraFacing(QNCameraFacing.FRONT)\n .setVideoCaptureConfig(QNVideoCaptureConfigPreset.CAPTURE_640x480) // 配置预览格式\n .setVideoEncoderConfig(new QNVideoEncoderConfig(640, 480, 30, 800)); // 配置编码参数\n mCameraVideoTrack = QNRTC.createCameraVideoTrack(cameraVideoTrackConfig);\n \n\n其中:\n\n 1. [QNVideoCaptureConfig](https://developer.qiniu.com/rtc/api/8700/QNVideoCaptureConfig) 用来配置摄像头采集参数,包括分辨率和帧率等;设置时可以使用 SDK 提供的预设值,详情可参考 [QNVideoCaptureConfigPreset](https://developer.qiniu.com/rtc/api/8731/video-capture-config-preset-android)。\n 2. [QNVideoEncoderConfig](https://developer.qiniu.com/rtc/api/8701/QNVideoEncoderConfig) 用来配置视频的编码参数,包括分辨率、帧率和码率(kbps)等。\n 3. [QNVideoCaptureConfig](https://developer.qiniu.com/rtc/api/8700/QNVideoCaptureConfig) 和 [QNVideoEncoderConfig](https://developer.qiniu.com/rtc/api/8701/QNVideoEncoderConfig) 的配置可以缺省,SDK 内部默认提供的采集编码参数为 640x480、20fps、800kbps\n\n在创建好\n[QNCameraVideoTrack](https://developer.qiniu.com/rtc/api/8640/QNCameraVideoTrack)\n之后,就可以通过调用 SDK 提供的相关方法进行摄像头的相关操作:\n\n## 设置事件监听\n\n通过调用 `QNCameraVideoTrack.setCameraEventListener` 接口进行摄像头事件的回调监听。\n\n \n \n public void setCameraEventListener(QNCameraEventListener listener);\n \n\n`QNCameraEventListener` 回调定义如下:\n\n \n \n interface QNCameraEventListener {\n int[] onCameraOpened(List<Size> sizes, List<Integer> fpsAscending); // 根据返回的设备能力选择采集参数\n void onCaptureStarted(); // 开始采集时触发\n void onCaptureStopped(); // 停止采集时触发\n void onError(int errorCode, String description); // 摄像头发生错误时触发\n }\n \n\n该回调监听可用来选择期望的采集能力、监听摄像头的相关异常等,详情可参考\n[QNCameraEventListener](https://developer.qiniu.com/rtc/api/8637/QNCameraEventListener)\n接口文档\n\n## 开始/停止摄像头采集\n\n通过调用 `QNCameraVideoTrack.startCapture` 接口进行摄像头采集,通过调用\n`QNCameraVideoTrack.stopCapture` 接口停止摄像头采集,通过调用 `QNCameraVideoTrack.play`\n设置摄像头采集的预览窗口。\n\n \n \n public void startCapture();\n public void stopCapture();\n public void play(QNRenderView view);\n \n\n> * 由于 Android 中的相机资源是单例的,若应用占用了相机资源则会导致其他应用无法获取到相机资源。SDK 支持在通话过程中可以通过\n> `QNCameraVideoTrack.startCapture` 获取相机资源,通过 `QNCameraVideoTrack.stopCapture`\n> 释放相机资源。\n> * 若摄像头采集开启失败,会通过\n> [QNCameraEventListener.onError](https://developer.qiniu.com/rtc/api/8637/QNCameraEventListener#onError)\n> 监听回调错误信息,错误码请参考[设备采集相关错误码](https://developer.qiniu.com/rtc/development_guidelines/9904/rtc-\n> error-code-android#2)。\n>\n\n基于 [Android\n行为变更](https://developer.android.com/about/versions/pie/android-9.0-changes-\nall#bg-sensor-access)的声明,Android 9 之后的设备将无法后台进行音视频的采集。\n\n * 若您有后台连麦的需求,可参考 [Android 官网相关说明](https://developer.android.com/guide/topics/media/camera)在退后台后使用[前台服务](https://developer.android.com/guide/components/services?hl=zh-cn#Foreground)让应用正常工作。\n * 若您不需要后台连麦,可以在 Activity `onResume`、`onPause` 等生命周期函数中分别调用 [QNCameraVideoTrack.startCapture](https://developer.qiniu.com/rtc/api/8640/QNCameraVideoTrack#startCapture) 和 [QNCameraVideoTrack.stopCapture](https://developer.qiniu.com/rtc/api/8640/QNCameraVideoTrack#stopCapture) 方法进行 Camera 采集的开启和关闭操作。\n\n## 开启/关闭预览\n\n通过调用 `QNCameraVideoTrack.setPreviewEnabled` 接口进行预览画面的开关控制:\n\n \n \n public void setPreviewEnabled(boolean isEnabled)\n \n\n## 开启/关闭闪光灯\n\n通过调用 `QNCameraVideoTrack.turnLightOn` 接口开启闪光灯,通过调用\n`QNCameraVideoTrack.turnLightOff` 接口关闭闪光灯:\n\n \n \n public boolean turnLightOn()\n public boolean turnLightOff()\n \n\n## 切换摄像头\n\n通过调用 `QNCameraVideoTrack.switchCamera` 接口进行摄像头的切换。\n\n \n \n public void switchCamera(QNCameraSwitchResultCallback callback)\n \n\n其中,切换成功与否会通过\n[QNCameraSwitchResultCallback](https://developer.qiniu.com/rtc/api/8639/QNCameraSwitchResultCallback)\n回调出来,若不需要结果回调,可以传入 null。\n\n> 相机在启动或使用过程中可能会遇到一些问题,在此情况下 SDK 会在 `QNCameraEventListener.onError`\n> 中回调到上层,详情可参考\n> [QNCameraEventListener](https://developer.qiniu.com/rtc/api/8637/QNCameraEventListener)。\n\n## 设置缩放\n\n通过调用 `QNCameraVideoTrack.setZoom(float zoom)` 接口对相机采集的画面进行缩放。需要注意的是 setZoom\n里的参数必须是通过调用 `QNCameraVideoTrack.getZooms()` 接口获取到的列表里的数值,如果\n`QNCameraVideoTrack.getZooms()` 接口获取到的列表为空,即代表不支持缩放设置:\n\n \n \n public void setZoom(float zoom);\n public List<Float> getZooms();\n \n\n## 开启/关闭镜像\n\nSDK 内提供了预览镜像和采集镜像两种镜像接口。通过调用 `QNCameraVideoTrack.setPreviewMirror(boolean\nmirror)` 接口即可开启或关闭预览镜像,开启了预览镜像仅仅在本地预览才会镜像,远端看还是正常的画面;通过调用\n`QNCameraVideoTrack.setMirror(boolean mirror)`\n接口即可开启或关闭采集镜像,若开启了采集镜像本地预览和远端都将会显示镜像画面:\n\n \n \n public void setMirror(boolean mirror);\n public void setPreviewMirror(boolean mirror);\n \n\n## 美颜\n\n通过调用 `QNCameraVideoTrack.setBeauty` 接口进行内置美颜的参数配置。其中,美颜的开关可以通过 QNBeautySetting\n来设置,具体的美颜配置可以参考\n[QNBeautySetting](https://developer.qiniu.com/rtc/api/8636/QNBeautySetting)。\n\n \n \n public void setBeauty(QNBeautySetting beautySetting)\n \n\n如需接入外部美颜或滤镜,可以通过 `QNCameraVideoTrack.setVideoFrameListener` 接口设置\n[QNVideoFrameListener](https://developer.qiniu.com/rtc/api/8704/QNVideoFrameListener)\n回调来对接外部第三方美颜或者滤镜。\n\n> 需要注意的是,由于 Android 摄像头设备角度的原因,在竖屏情况下 SDK\n> 内部会对图像进行旋转,在竖屏情况的宽高设置跟实际图像会有所差别。比如:在横屏情况下发布 `1280 * 720` 的视频图像,那么设置为 `new\n> QNVideoEncoderConfig(1280, 720, DEFAULT_FPS,\n> DEFAULT_BITRATE)`即可;但如果想要在竖屏情况下发布 `720 * 1280` 的视频图像,那么由于上述原因应设置为 `new\n> QNVideoEncoderConfig(1280, 720, DEFAULT_FPS, DEFAULT_BITRATE)`。另外,在 [CDN\n> 转推](https://developer.qiniu.com/rtc/development_guidelines/8770/turn-the-\n> cdn-push-android)合流配置中的宽高与此处的配置不同,合流配置的宽高需要以实际宽高为准。\n\n######\n\n# 屏幕录制视频 Track\n\n[QNScreenVideoTrack](https://developer.qiniu.com/rtc/api/8687/QNScreenVideoTrack)\n为屏幕录制的本地 Track,录屏连麦的主要步骤如下:\n\n## 判断设备是否支持屏幕录制\n\n屏幕录制依赖 Android 系统版本,可通过 SDK 提供的如下接口判断是否支持:\n\n \n \n static boolean isScreenCaptureSupported();\n \n\n示例代码如下:\n\n \n \n boolean isSupported = QNScreenVideoTrack.isScreenCaptureSupported();\n \n\n## 发起屏幕录制请求\n\nSDK 提供如下方法进行屏幕请求的发起:\n\n \n \n static boolean requestPermission(Activity activity);\n \n\n示例代码如下:\n\n \n \n QNScreenVideoTrack.requestPermission(activity);\n \n\n当用户同意录屏请求后,会通过系统的 `onActivityResult` 进行通知,在收到录屏请求的返回后,可通过 SDK 提供的\n`checkActivityResult` 方法进行处理,如果接口返回 true,便可以创建 Screen Track 进行屏幕录制了。\n\n示例代码如下:\n\n \n \n @Override\n protected void onActivityResult(int requestCode, int resultCode, @Nullable Intent data) {\n super.onActivityResult(requestCode, resultCode, data);\n if (requestCode == QNScreenVideoTrack.SCREEN_CAPTURE_PERMISSION_REQUEST_CODE &&\n QNScreenVideoTrack.checkActivityResult(requestCode, resultCode, data)) {\n // 创建 Screen Track\n createScreenTrack();\n }\n }\n \n\n## 创建 Screen Track\n\n在通过了屏幕录制申请后,可以通过如下方式进行 Screen Track 的创建:\n\n \n \n QNScreenVideoTrackConfig screenVideoTrackConfig = new QNScreenVideoTrackConfig(Config.TAG_SCREEN_TRACK)\n .setVideoEncoderConfig(createEncoderConfig());\n mScreenVideoTrack = QNRTC.createScreenVideoTrack(screenVideoTrackConfig);\n \n\n其中,[QNVideoEncoderConfig](https://developer.qiniu.com/rtc/api/8701/QNVideoEncoderConfig)\n用来配置视频的编码参数,包括分辨率、帧率和码率(kbps)等;\n录屏时建议分辨率和屏幕分辨率比例保存一致,避免录屏画面有黑边或者不清晰,具体可[参考](https://github.com/pili-\nengineering/QNRTC-Android/blob/master/QNRTC-API-\nExamples/app/src/main/java/com/qiniu/droid/rtc/api/examples/activity/ScreenCaptureActivity.java)。\n\n# 外部导入视频 Track\n\nSDK 外部导入视频连麦支持导入 **NV21 数据** 和 **纹理数据** 两种格式的数据,使用方式如下:\n\n## 创建外部导入视频 Track\n\n[QNCustomVideoTrack](https://developer.qiniu.com/rtc/api/8649/QNCustomVideoTrack)\n为外部数据导入视频 track,创建方式如下:\n\n \n \n QNCustomVideoTrackConfig customVideoTrackConfig = new QNCustomVideoTrackConfig(TAG_FOR_EXTERNAL_IMPORT_VIDEO)\n .setVideoEncoderConfig(new QNVideoEncoderConfig(640, 480, 30, 800));\n mCustomVideoTrack = QNRTC.createCustomVideoTrack(customVideoTrackConfig);\n \n\n## 数据导入\n\n### 导入 NV21 数据\n\nSDK 支持导入 NV21 的数据,在创建好\n[QNCustomVideoTrack](https://developer.qiniu.com/rtc/api/8649/QNCustomVideoTrack)\n之后,可通过如下方式推送数据:\n\n \n \n QNVideoFrame videoFrame = new QNVideoFrame();\n videoFrame.buffer = data; // NV21 数据\n videoFrame.width = width; // 视频帧的宽度\n videoFrame.height = height; // 视频帧的高度\n videoFrame.rotation = 0; // 视频帧的角度\n videoFrame.timestampNs = ts; // 视频帧的时间戳,以 ns 为单位\n mCustomVideoTrack.pushVideoFrame(videoFrame);\n \n\n> 为兼容所有机型,导入 NV21 数据时,建议选择软编码的方式进行导入。\n\n### 导入纹理数据\n\nSDK 支持导入纹理数据,在创建好\n[QNCustomVideoTrack](https://developer.qiniu.com/rtc/api/8649/QNCustomVideoTrack)\n之后,可通过如下方式推送数据:\n\n \n \n QNVideoFrame videoFrame = new QNVideoFrame();\n videoFrame.texture = QNTexture.create(\n mTextureType == QNTexture.TextureType.OES ? mOESTexID : mCanvas.getCanvasTexID(),\n mTextureType,\n mMatrix,\n mCanvasThread.getHandler());\n videoFrame.width = mWidth;\n videoFrame.height = mHeight;\n videoFrame.rotation = 0;\n videoFrame.timestampNs = ts;\n mCustomVideoTrack.pushVideoFrame(videoFrame);\n \n\n其中:\n\n 1. [TextureType](https://developer.qiniu.com/rtc/api/8691/QNTexture#TextureType) 为纹理类型,需要根据实际类型指定为 `OES` 或者 `RGB`。\n 2. Matrix 为 4x4 的纹理变换矩阵。根据纹理类型的不同,处理方式也有所区别: \n * 如果推送的纹理为 OES 纹理,则需要传入对应的纹理变换矩阵。\n * 如果推送的纹理为 RGB 纹理,则通常只需传入单位矩阵即可。\n 3. 纹理导入需要 OpenGL 上下文,因此,Handler 需要指定为纹理所在线程的 Handler。\n\n# 麦克风音频 Track\n\n[QNMicrophoneAudioTrack](https://developer.qiniu.com/rtc/api/8667/QNMicrophoneAudioTrack)\n为麦克风采集的音频 Track,如需以麦克风采集数据作为音频源,仅需创建一个\n[QNMicrophoneAudioTrack](https://developer.qiniu.com/rtc/api/8667/QNMicrophoneAudioTrack)\n并发布即可,其创建方式如下:\n\n \n \n QNMicrophoneAudioTrackConfig microphoneAudioTrackConfig = new QNMicrophoneAudioTrackConfig(TAG_AUDIO)\n .setAudioQuality(QNAudioQualityPreset.STANDARD);\n mMicrophoneAudioTrack = QNRTC.createMicrophoneAudioTrack(microphoneAudioTrackConfig);\n \n\n其中,[QNAudioQuality](https://developer.qiniu.com/rtc/api/8634/QNAudioQuality)\n代表音频的质量参数,包括采样率、声道数、位宽以及编码码率,SDK 有提供对应的预设以方便选择,可参考\n[QNAudioQualityPreset](https://developer.qiniu.com/rtc/api/8635/QNAudioQualityPreset)。\n\n> **注意:**\n>\n> 1. 从 v5.2.3 开始,SDK 支持同时创建并发布多路音频 Track;v5.2.3 之前仅支持一路音频\n> Track,[QNMicrophoneAudioTrack](https://developer.qiniu.com/rtc/api/8667/QNMicrophoneAudioTrack)\n> 和\n> [QNCustomAudioTrack](https://developer.qiniu.com/rtc/api/8646/QNCustomAudioTrack)\n> 实例不能同时创建。\n> 2. 在音视频通话的场景下,为了获得更好的通话体验,建议使用单声道的音频配置。\n>\n\n# 外部导入音频 Track\n\n[QNCustomAudioTrack](https://developer.qiniu.com/rtc/api/8646/QNCustomAudioTrack)\n为外部导入音频 track,如需导入音频数据作为音频源,仅需创建一个\n[QNCustomAudioTrack](https://developer.qiniu.com/rtc/api/8646/QNCustomAudioTrack)\n即可,然后通过调用 `QNCustomAudioTrack.pushAudioFrame(QNAudioFrame frame)` 进行外部音频数据的导入。\n\n支持的音频数据格式为:PCM 格式,16 bit 位宽。\n\n使用方式可参考如下示例:\n\n \n \n QNAudioFrame audioFrame = new QNAudioFrame(buffer, size, dataWidth, sampleRate, channels);\n mCustomAudioTrack.pushAudioFrame(audioFrame);\n \n\n> 从 v5.2.3 开始,SDK 支持同时创建并发布多路音频 Track;v5.2.3 之前仅支持一路音频\n> Track,[QNMicrophoneAudioTrack](https://developer.qiniu.com/rtc/api/8667/QNMicrophoneAudioTrack)\n> 和\n> [QNCustomAudioTrack](https://developer.qiniu.com/rtc/api/8646/QNCustomAudioTrack)\n> 实例不能同时创建。\n\n# 示例代码\n\n音视频采集场景的示例代码可参考 [QNRTC-API-Examples](https://github.com/pili-\nengineering/QNRTC-Android/tree/master/QNRTC-API-Examples)。\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频房间管理"

},

{

"from": "gpt",

"value": "[实时音视频](https://developer.qiniu.com/rtc) > 使用指南 > Android >房间管理\n\n# 房间管理\n\n最近更新时间: 2021-11-26 15:19:24\n\n**房间**\n是对音视频对话空间的抽象,用于隔离不同的通话过程,保障数据的安全及独立。同一房间内的用户可以互相接收对方的音视频数据。本部分介绍如何进行房间管理,获取房间信息、用户信息以及如何实现踢人等常见功能。\n\n> *\n> 加入、离开房间代表一次音视频通话的开始和结束,一次会话仅需调用一次加入、离开的操作即可,无需重复调用。加入房间后对于音视频数据的发送和接收,可参考[发布和订阅](https://developer.qiniu.com/rtc/development_guidelines/8769/publish-\n> and-subscribe-android)相关流程。\n> * 加入房间需要携带相应的\n> [RoomToken](https://developer.qiniu.com/rtc/quick_start/9909/the-rtc-basic-\n> concept#room_token),[RoomToken](https://developer.qiniu.com/rtc/quick_start/9909/the-\n> rtc-basic-concept#room_token) 需通过您的服务端生成,签算方式可参考 [RoomToken\n> 签发服务](https://developer.qiniu.com/rtc/development_guidelines/8813/roomToken)。\n>\n\n# 房间的生命周期\n\n * 当用户加入的房间不存在时,七牛后台服务会自动创建对应的房间。\n * 若房间内的所有用户都已离开,那么房间维持空状态 10s 后将会自动关闭。\n * 若房间为服务端创建,且创建后无用户进入,那么房间维持空状态 30s 后将会自动关闭。\n * 若房间内的用户由于断网等原因,30s 未向七牛后台服务通信,则该用户将被视为退出房间。\n\n# 加入房间\n\n本地调用 [QNRTCClient.join(String\ntoken)](https://developer.qiniu.com/rtc/api/8684/QNRTCClient#join%5B1/2%5D) 通过\nroomToken 加入房间。\n\n \n \n public void join(String token);\n public void join(String token, String userData);\n \n\n示例代码如下:\n\n \n \n mClient.join(token);\n \n\n> 1. 请确保在 `QNConnectionState.DISCONNECTED` 状态下调用该接口加入房间,否则接口调用无效\n> 2. 加入房间时根据业务需求,每个用户可通过 `userData` 携带自定义数据\n>\n\n关于 roomToken 的签算规则,可查阅 [RoomToken\n的签算](https://doc.qnsdk.com/rtn/docs/server_overview#1)文档。\n\n本地加入房间成功后,会触发如下回调:\n\n**本地用户收到的回调:**\n\n调用 [QNRTCClient.join(String\ntoken)](https://developer.qiniu.com/rtc/api/8684/QNRTCClient#join%5B1/2%5D)\n接口后,会触发\n[QNClientEventListener.onConnectionStateChanged](https://developer.qiniu.com/rtc/api/8643/QNClientEventListener#onConnectionStateChanged)\n监听回调房间状态改变的通知\n\n \n \n public interface QNClientEventListener {\n // 当房间状态改变时会触发此回调\n void onConnectionStateChanged(QNConnectionState state, @Nullable QNConnectionDisconnectedInfo info);\n }\n \n\n * 若加入房间成功,会回调 [QNConnectionState.CONNECTED](https://developer.qiniu.com/rtc/api/8645/QNConnectionState#CONNECTED) 状态。\n * 若加入房间失败,会回调 [QNConnectionState.DISCONNECTED](https://developer.qiniu.com/rtc/api/8645/QNConnectionState#DISCONNECTED) 状态,同时可以通过 [QNConnectionDisconnectedInfo](https://developer.qiniu.com/rtc/api/8644/QNConnectionDisconnectedInfo) 获取[失败的原因](https://developer.qiniu.com/rtc/api/8644/QNConnectionDisconnectedInfo#Reason)以及对应的[错误码](https://developer.qiniu.com/rtc/development_guidelines/9904/rtc-error-code-android#1)\n\n**远端用户收到的回调:**\n\n \n \n public interface QNClientEventListener {\n // 当远端用户加入房间时会触发此回调\n void onUserJoined(String remoteUserId, String userData);\n }\n \n\n* * *\n\n# 离开房间\n\n本地调用\n[QNRTCClient.leave()](https://developer.qiniu.com/rtc/api/8684/QNRTCClient#leave)\n退出房间。本地退出房间成功后,会触发如下回调:\n\n**本地用户收到的回调:**\n\n \n \n public interface QNClientEventListener {\n // 当房间状态改变时会触发此回调,成功离开房间后,回调状态为 QNConnectionState.DISCONNECTED,QNConnectionDisconnectedInfo 回调 Reason 为 LEAVE\n void onConnectionStateChanged(QNConnectionState state, @Nullable QNConnectionDisconnectedInfo info);\n }\n \n\n**远端用户收到的回调:**\n\n \n \n public interface QNClientEventListener {\n // 当远端用户离开房间时会触发此回调\n void onUserLeft(String remoteUserID);\n }\n \n\n* * *\n\n# 房间信息\n\n## 获取房间内远端用户信息\n\n本地可调用 [QNRTCClient.getRemoteUser(String\nuserID)](https://developer.qiniu.com/rtc/api/8684/QNRTCClient#getRemoteUser)\n接口获取音视频通话房间中的指定用户。\n\n \n \n public QNRemoteUser getRemoteUser(String userID);\n \n\n本地可调用\n[QNRTCClient.getRemoteUsers()](https://developer.qiniu.com/rtc/api/8684/QNRTCClient#getRemoteUsers)\n接口获取音视频通话房间中的远端用户列表。\n\n \n \n public List<QNRemoteUser> getRemoteUsers();\n \n\n其中,[QNRemoteUser](https://developer.qiniu.com/rtc/api/8677/QNRemoteUser)\n代表远端用户的信息,通过该对象可以获取指定 user 发布的音视频列表以及本地对其的订阅情况。\n\n## 获取房间状态信息\n\n本地可以调用\n[QNRTCClient.getConnectionState()](https://developer.qiniu.com/rtc/api/8684/QNRTCClient#getConnectionState)\n接口获取音视频通话的房间状态信息。\n\n \n \n public QNConnectionState getConnectionState();\n \n\n其中,[QNConnectionState](https://developer.qiniu.com/rtc/api/8645/QNConnectionState)\n包含如下状态:\n\n \n \n public enum QNConnectionState {\n // 未链接状态, SDK 出现无法恢复错误时也进入该状态\n DISCONNECTED,\n // 正在连接状态, 加入房间时首先进入该状态,表示开始连接房间服务\n CONNECTING,\n // 连接成功状态,在完成和房间服务连接后进入该状态\n CONNECTED,\n // 正在重连状态,当和房间的已有连接由于网络中断、网络异常等原因断开,SDK 进行周期性重连时进入该状态\n RECONNECTING,\n // 重连成功状态,当从 RECONNECTING 状态,重新和房间服务建立连接后进入该状态\n RECONNECTED\n }\n \n\n* * *\n\n# 踢人\n\n## 客户端踢人\n\n客户端 SDK 未提供踢人的接口,但是踢人操作可以通过自定义消息来实现。实现步骤可参考如下:\n\n 1. 业务侧协商定义好踢人消息的格式规范\n 2. 踢人方在执行踢人操作时,向指定用户发送协商好的踢人消息\n 3. 被踢方接收到踢人消息后,主动离开当前房间\n\n示例代码参考如下:\n\n**踢人方:**\n\n踢人方发送协商好的踢人消息:\n\n \n \n mClient.sendMessage(Collections.singletonList(\"userID\"), \"messageID\", \"kickOut\");\n \n\n其中,自定义消息的使用方式可以参考\n[QNRTCClient.sendMessage](https://developer.qiniu.com/rtc/api/8684/QNRTCClient#sendMessage%5B1/2%5D)。\n\n**被踢方:**\n\n被踢方监听\n[QNClientEventListener.onMessageReceived](https://developer.qiniu.com/rtc/api/8643/QNClientEventListener#onMessageReceived)\n回调接口来接收踢人消息,并在收到消息后主动离开房间:\n\n \n \n public interface QNClientEventListener {\n @Override\n public void onMessageReceived(QNCustomMessage message) {\n if (\"kickOut\".equals(message.getContent())) {\n // 离开房间\n }\n }\n }\n \n\n## 服务端踢人\n\n服务端提供了踢人的接口,详情可参考[服务端文档](https://developer.qiniu.com/rtc/api/8815/api-\nroom),当服务端执行踢人操作后,会触发被踢方\n[QNClientEventListener.onConnectionStateChanged](https://developer.qiniu.com/rtc/api/8643/QNClientEventListener#onConnectionStateChanged)\n回调:\n\n \n \n public interface QNClientEventListener {\n @Override\n void onConnectionStateChanged(QNConnectionState state, @Nullable QNConnectionDisconnectedInfo info){\n if (state == QNConnectionState.DISCONNECTED \n && info != null \n && info.getReason() == QNConnectionDisconnectedInfo.Reason.KICKED_OUT) {\n // 您已被服务端踢出房间\n }\n }\n }\n \n\n其中,被服务端踢出房间的场景下\n[QNConnectionDisconnectedInfo](https://developer.qiniu.com/rtc/api/8644/QNConnectionDisconnectedInfo)\n回调的状态为 `QNConnectionState.DISCONNECTED`,同时\n`QNConnectionDisconnectedInfo.Reason` 为 `KICKED_OUT`。\n\n以上内容是否对您有帮助?\n\n"

}

] | qiniu developer | 1 |

[

{

"from": "human",

"value": "如何处理七牛云的实时音视频发布和订阅"

},

{

"from": "gpt",